得芯片者得天下。我们可以把这句话再延伸一下说,得人工智能芯片者得未来的天下。

对于智能终端厂商来说,能够自研SoC芯片似乎才是顶级实力的象征。众所周知,盘踞全球智能手机前三甲的三星,华为,苹果,无一例外都拥有自研的SoC芯片。

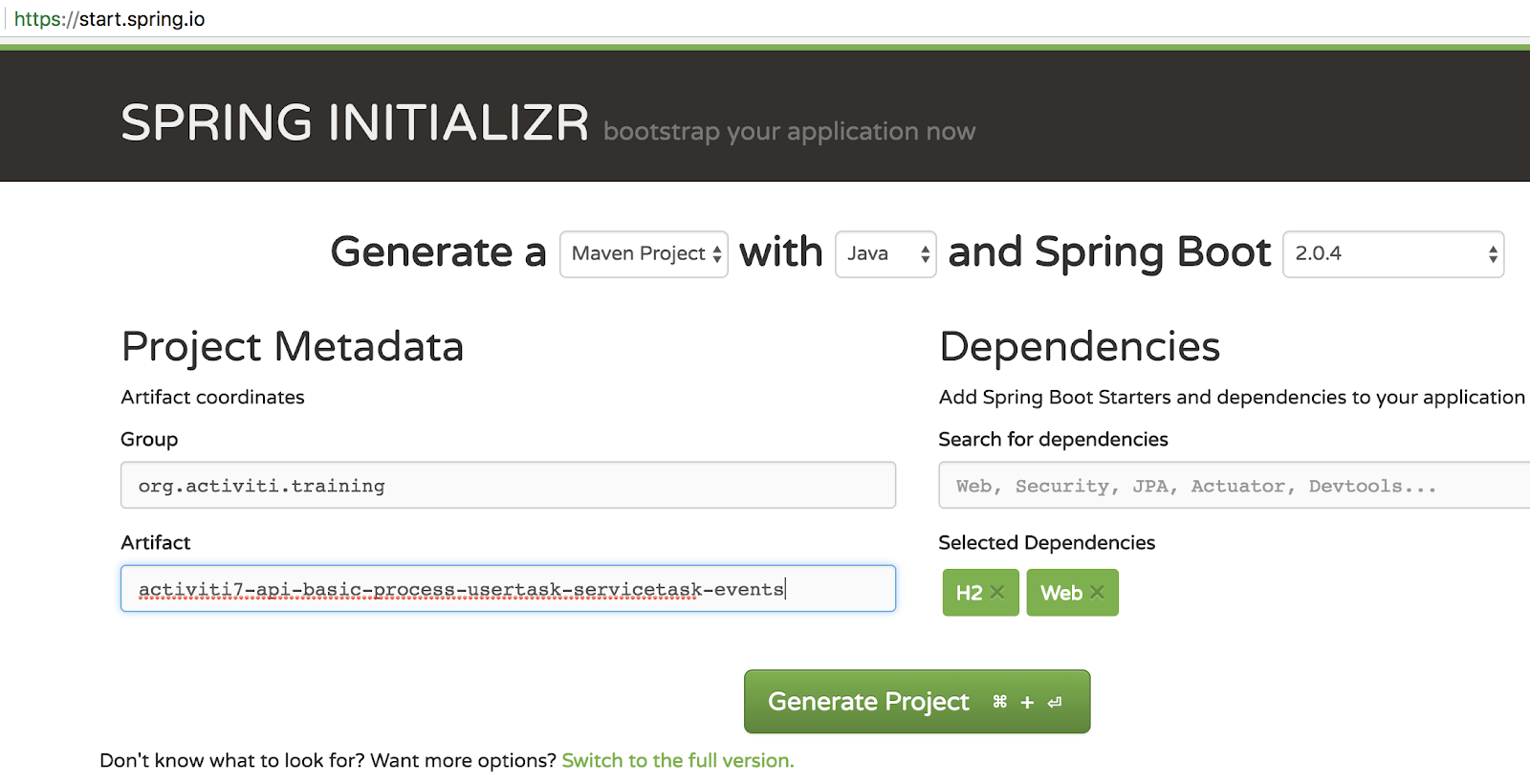

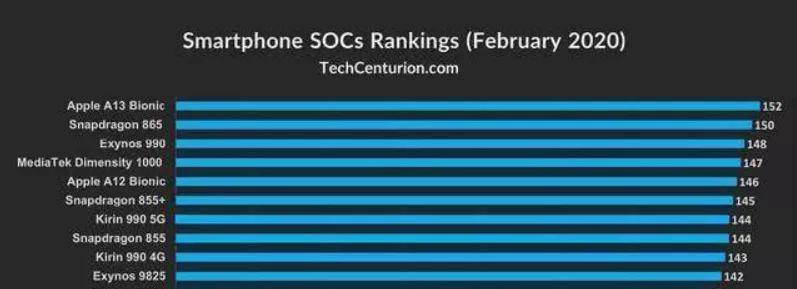

(2020年智能手机芯片跑分数据全球)

现在,经历了多年的辅助AI芯片的经验积累之后,谷歌终于要入场智能终端的核心硬件——SoC处理器芯片了。

据外媒Axois报告,谷歌在自研处理器方面取得了显著进步,最近其自主研发的SoC芯片已经成功流片。

据悉,该芯片是谷歌与三星联合开发,采用5 nm工艺制造,“2 + 2 + 4”三架构设计的8核CPU集群,以及搭载全新手臂公版架构的GPU,同时在ISP和转专业上集成了谷歌视觉核心AI视觉处理器。这让谷歌的终端芯片能够更好地支持AI技术,比如大幅提升谷歌助手的交互体验。

在上市计划上,谷歌的这一SoC处理器芯片预计将于率先部署在下一代像素手机以及谷歌笔记本Chromebook中。

谷歌的这一举动被视为对苹果自研处理器模式的靠拢,从“原生系统+最主流旗舰芯片”变为“原生系统+自研芯片”,谷歌的用意肯定不仅是想摆脱高通芯片的钳制,更重要的是想通过自研芯片实现更好的软硬件结合,使得安卓系统在自家硬件上发挥更大的性能优势。

我们其实知道,自研芯片并不能在硬件利润上带给谷歌更多的价值,其中最有价值的地方在于将谷歌AI上面的优势通过软硬件的结合,在智能终端上得到更好的应用。

我们也都知道,谷歌在AI芯片上入局最早,实力强劲。然而AI芯片的技术有多强,AI技术和芯片研发有哪些相互促进的关系?相信很多人还是不明就里的,而这正是我们接下来要去深入探究的。

从云端到终边端,谷歌AI芯片的进阶之路

在谷歌的TPU(张量处理单元,张量处理单元)处理器推出之前,大部分的机器学习以及图像处理算法一直都是跑在GPU与FPGA这两种通用芯片上面的。而提出了深度学习开源框架TensorFlow的谷歌则专门做出这样一款为TensorFlow算法设计的专用芯片。

TPU就这样诞生了,然而让TPU的声名远播却是在AlphaGo大战李世石的人机围棋赛。据说,当时谷歌为TPU其实下了另一盘大棋的。因为在挑战李世石之前,AlphaGo是跑在176个1202个CPU和GPU上面与棋手樊麾比赛的。这让看过对弈过程的李世石很有信心。然而在比赛前几个月,AlphaGo的硬件平台换上了TPU,这让AlphaGo的实力很快得到成长,后面的对战局势让李世石就吃尽了苦头。

(谷歌TPU芯片)

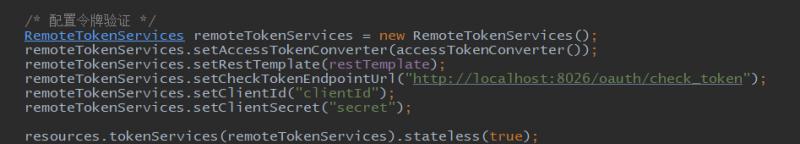

TPU是一种专用集成电路(ASIC),作为专门在谷歌云使用的人工智能芯片,其使命就在于加速谷歌人工智能落地的速度。在2017年谷歌公布的第二代TPU上,其浮点运算能力高达每180秒万亿次,既可以用于推理,也可以用做训练。而到2018了年的TPU3.0版本,其计算性能相比TPU 2.0提升八倍,可达每1000秒万亿次浮点计算。

此后,谷歌的AI布局逐渐走向边缘侧。在2017年的谷歌云服务年会上,正式发布其边缘技术,并推出了谷歌边缘TPU。

边缘TPU是谷歌专为在边缘运行TensorFlow Lite毫升模型而设计的ASIC芯片.Edge TPU可用于越来越多的工业使用场景,如预测性维护,异常检测,机器视觉,机器人学,语音识别,也可以应用于本地部署,医疗保健,零售,智能空间,交通运输等各个领域。

边缘TPU体型小,能耗低,因此只负责AI加速判别,加速推算,仅为加速器,辅助处理器的角色,可以在边缘部署高精度AI,是对CPU、GPU, FPGA以及其他在边缘运行AI的ASIC解决方案的补充。

谷歌还在去年推出了基于边缘TPU芯片的等一系列开发硬件,以及本地化AI平台珊瑚,为边缘侧提供优质,易部署的AI解决方案。

尽管TPU和边缘TPU主要是对深度学习起到运算推理加速的辅助服务器,但我们仍然能够看到谷歌在AI芯片上的布局野心。从云端,到边缘端和手机智能终端,正是理解谷歌AI芯片的内在逻辑。

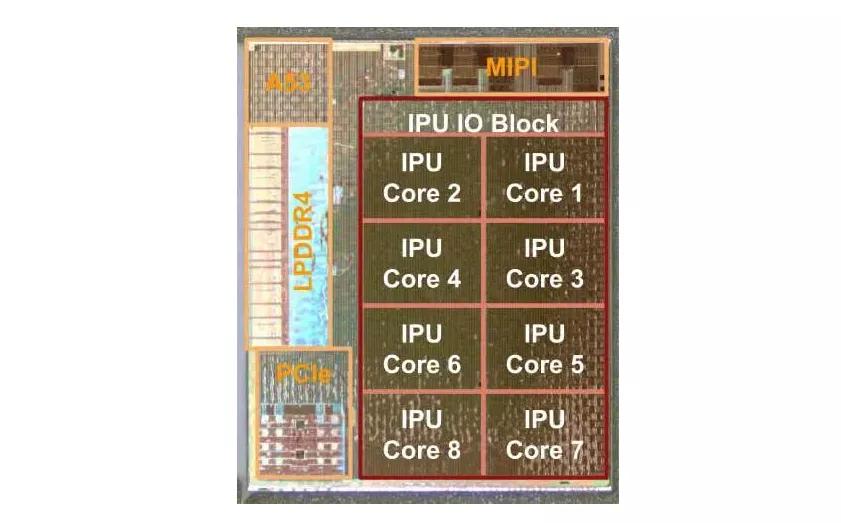

(像素的视觉核心)