这篇文章将为大家详细讲解有关用python实现前向分词最大匹配算法的案例分析,小编觉得挺实用的,因此分享给大家做个参考,希望大家阅读完这篇文章后可以有所收获。

分词是自然语言处理的一个基本工作,中文分词和英文不同,字词之间没有空格。中文分词是文本挖掘的基础,对于输入的一段中文,成功的进行中文分词,可以达到电脑自动识别语句含义的效果。中文分词技术属于自然语言处理技术范畴,对于一句话,人可以通过自己的知识来明白哪些是词,哪些不是词,但如何让计算机也能理解?其处理过程就是分词算法。

可以将中文分词方法简单归纳为:

1。基于词表的分词方法

2。基于统计的分词方法

3。基于序列标记的分词方法

其中,基于词表的分词方法最为简单,根据起始匹配位置不同可以分为:

1。前向最大匹配算法

2。后向最大匹配算法

3。双向最大匹配算法

三种方法思想都很简单,今天就用python实现前向最大匹配算法。

词分词是一个Java实现的分布式的中文分词组件,提供了多种基于词典的分词算法,并利用ngram模型来消除歧义。能准确识别英文,数字,以及日期,时间等数量的词,能识别人名,地名,组织机构名等未登录词。能通过自定义配置文件来改变组件行为,能自定义用户词库,自动检测词库变化,支持大规模分布式环境,能灵活指定多种分词算法,能使用精炼功能灵活控制分词结果,还能使用词性标注,同义标注,反义标注,拼音标注等功能,同时还无缝和Lucene, Solr, ElasticSearch,卢克集成。

前向最大匹配算法,顾名思义,就是从待分词句子的左边向右边搜索,寻找词的最大匹配。我们需要规定一个词的最大长度,每次扫描的时候寻找当前开始的这个长度的词来和字典中的词匹配,如果没有找的到,就缩短长度继续寻找,直到找到字典中的词或者成为单字。

<强>具体代码实现

获取分词函数:<代码> getSeg(文本):

def getSeg(文本): #句子为空 如果没有文本: 返回& # 39;& # 39; #句子成为一个词 如果len(文本)==1: 返回文本 #此处写了一个递归方法 如果在word_dict文本: 返回文本 其他: ?len(文本)- 1 文本=文本(0:小) 返回getSeg(文本)

主函数:<代码>主要()

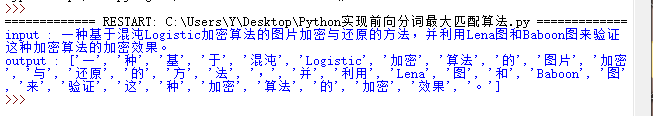

def main (): 全球test_str word_dict test_str=test_str.strip () #正向最大匹配分词测试最大长度5 max_len=max (len(字)字word_dict) result_str=[] #保存分词结果 result_len=0 打印(& # 39;输入:& # 39;,test_str) 而test_str: tmp_str=test_str [0 max_len): seg_str=getSeg (tmp_str) seg_len=len (seg_str) result_len=result_len + seg_len 如果seg_str.strip (): result_str.append (seg_str) test_str=test_str [seg_len:] 打印(& # 39;输出:& # 39;,result_str)

字典:

word_dict=[& # 39;混沌& # 39;,& # 39;物流# 39;,& # 39;算法& # 39;,& # 39;图片& # 39;,& # 39;加密& # 39;,& # 39;利用& # 39;,& # 39;还原& # 39;,& # 39;莉娜# 39;,& # 39;验证& # 39;,& # 39;狒狒# 39;,& # 39;效果& # 39;]

测试句子:

关于用python实现前向分词最大匹配算法的案例分析就分享到这里了,希望以上内容可以对大家有一定的帮助,可以学到更多知识。如果觉得文章不错,可以把它分享出去让更多的人看的到。