这篇文章给大家介绍使用python怎么自动下载图片,内容非常详细,感兴趣的小伙伴们可以参考借鉴,希望对大家能有所帮助。

python的数据类型:1。数字类型,包括int(整型),长(长整型)和浮子(浮点型)。2。字符串,分别是str类型和unicode类型。3。布尔型,Python布尔类型也是用于逻辑运算,有两个值:True(真)和虚假的(假)。4。列表,列表是Python中使用最频繁的数据类型,集合中可以放任何数据类型。5。元组,元组用“()”标识,内部元素用逗号隔开。6。字,字典典是一种键值对的集合。7。集合,集合是一个无序的,不重复的数据组合。

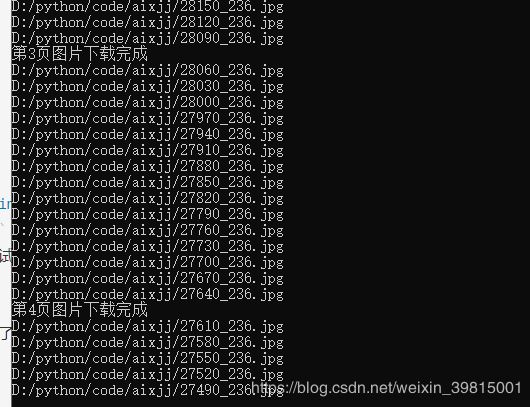

尝试运行爬虫,嘿,没想到行了:

#多进程版——抓取爱小姐姐网图片保存到本地

import 请求

得到lxml import etree as 等

import 操作系统

import 时间

得到multiprocessing import 池

#请求头

headers =, {

#才能用户代理,

& # 39;才能用户代理# 39;:,& # 39;Mozilla/5.0, (Windows NT 10.0;, Win64;, x64), AppleWebKit/537.36, (KHTML, like 壁虎),Chrome/78.0.3904.108 Safari/537.36 & # 39;

}

#待抓取网页基地址

时间=base_url & # 39; & # 39;

#保存图片基本路径

时间=base_dir & # 39; D:/python/代码/aixjj1/& # 39;

#保存图片

def savePic (pic_url):

#才能如果目录不存在,则新建

if 才能;not os.path.exists (base_dir):

,,,os.makedirs (base_dir)

,,

时间=arr 才能;pic_url.split (& # 39;/& # 39;

时间=file_name 才能;base_dir + arr [2] + arr [1]

打印(file_name)才能

#才能获取图片内容

时间=response 才能;requests.get (pic_url, headers =,头)

#写才能入图片

with 才能打开(file_name & # 39; wb # 39;), as 外交政策:

,,,for data 拷贝response.iter_content (128):

,,,,,fp.write(数据)

def geturl (url):

#请才能求页面地址

# url 才能=,base_url + str (k)

response 才能=,requests.get (=url url,, headers =,标题)

#请才能求状态码

code 才能=response.status_code

if 才能;code ==, 200:

,,,html =, et.HTML (response.text)

,,,#获取页面所有图片地址

,,,r =, html.xpath(& # 39;//李//img/@src& # 39;)

,,,#获取下一页的url

,,,# t =, html.xpath (& # 39;//div [@class=皃age"]/[@class=癱h"]/@href& # 39;) [1]

,,,for pic_url r:拷贝

,,,,,a =, & # 39; http: & # 39; + pic_url

,,,,,savePic (a)

if __name__ ==, & # 39; __main__ # 39;:

#才能获取要爬取的链接列表

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

#多进程版——抓取爱小姐姐网图片保存到本地

import 请求

得到lxml import etree as 等

import 操作系统

import 时间

得到multiprocessing import 池

#请求头

headers =, {

#才能用户代理,

& # 39;才能用户代理# 39;:,& # 39;Mozilla/5.0, (Windows NT 10.0;, Win64;, x64), AppleWebKit/537.36, (KHTML, like 壁虎),Chrome/78.0.3904.108 Safari/537.36 & # 39;

}

#待抓取网页基地址

时间=base_url & # 39; & # 39;

#保存图片基本路径

时间=base_dir & # 39; D:/python/代码/aixjj1/& # 39;

#保存图片

def savePic (pic_url):

#才能如果目录不存在,则新建

if 才能;not os.path.exists (base_dir):

,,,os.makedirs (base_dir)

,,

时间=arr 才能;pic_url.split (& # 39;/& # 39;

时间=file_name 才能;base_dir + arr [2] + arr [1]

打印(file_name)才能

#才能获取图片内容

时间=response 才能;requests.get (pic_url, headers =,头)

#写才能入图片

with 才能打开(file_name & # 39; wb # 39;), as 外交政策:

,,,for data 拷贝response.iter_content (128):

,,,,,fp.write(数据)

def geturl (url):

#请才能求页面地址

# url 才能=,base_url + str (k)

response 才能=,requests.get (=url url,, headers =,标题)

#请才能求状态码

code 才能=response.status_code

if 才能;code ==, 200:

,,,html =, et.HTML (response.text)

,,,#获取页面所有图片地址

,,,r =, html.xpath(& # 39;//李//img/@src& # 39;)

,,,#获取下一页的url

,,,# t =, html.xpath (& # 39;//div [@class=皃age"]/[@class=癱h"]/@href& # 39;) [1]

,,,for pic_url r:拷贝

,,,,,a =, & # 39; http: & # 39; + pic_url

,,,,,savePic (a)

if __name__ ==, & # 39; __main__ # 39;:

#才能获取要爬取的链接列表

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null