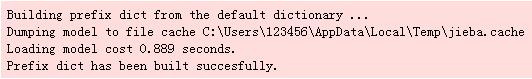

介绍 Python主要用来做什么 # ! python3

#,- *安康;编码:utf-8 - * -

import 操作系统,编解码器

import jieba

得到collections import 计数器

,

def get_words (txt):=,,seg_list jieba.cut (txt)=,c 计数器()

,for x seg_list拷贝:

if 才能len (x)在1,以及x !=, & # 39; \ r \ n # 39;:

,,c (x), +=1

,打印(& # 39;常用词频度统计结果& # 39;)

,for (k、v),拷贝c.most_common (100):

打印才能(& # 39;% s % s % s % d # 39;, %, (& # 39;, & # 39; * (5-len (k),, k, & # 39; * & # 39; * int (v/3), v))

,

if __name__ ==, & # 39; __main__ # 39;:

,with codecs.open (& # 39; 19 d.txt& # 39;,, & # 39; " # 39;,, & # 39; use utf8 # 39;), as f:

时间=txt 才能;f.read ()

之前,get_words (txt) 常用词频度统计结果

发才能展,* * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * *,212年

中才能国,* * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * *,168年

人才能民,* * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * *,157年

,,建设,* * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * *,148年

,社会主义,* * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * *,146年

,,坚持,* * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * *,130年

国才能家,* * * * * * * * * * * * * * * * * * * * * * * * * * * * * *,90年

全才能面,* * * * * * * * * * * * * * * * * * * * * * * * * * * * *,88年

制才能度,* * * * * * * * * * * * * * * * * * * * * * * * * * *,83年

,,实现,* * * * * * * * * * * * * * * * * * * * * * * * * * *,83年

推才能进,* * * * * * * * * * * * * * * * * * * * * * * * * * *,81年

政才能治,* * * * * * * * * * * * * * * * * * * * * * * * * *,80年

社才能会,* * * * * * * * * * * * * * * * * * * * * * * * * *,80年

特才能色,* * * * * * * * * * * * * * * * * * * * * * * * * *,79年

加才能强,* * * * * * * * * * * * * * * * * * * * * * *,71年

体才能系,* * * * * * * * * * * * * * * * * * * * * *,68年

文才能化,* * * * * * * * * * * * * * * * * * * * * *,66年

我才能们,* * * * * * * * * * * * * * * * * * * * *,64年

时才能代,* * * * * * * * * * * * * * * * * * * * *,63年

,,必须,* * * * * * * * * * * * * * * * * * * *,61年

,,经济,* * * * * * * * * * * * * * * * * * *,59

伟才能大,* * * * * * * * * * * * * * * * * * *,58岁

完才能善,* * * * * * * * * * * * * * * * *,51

我才能国,* * * * * * * * * * * * * * * *,50

推才能动,* * * * * * * * * * * * * * *,47岁

,现代化,* * * * * * * * * * * * * * *,47岁

,,安全,* * * * * * * * * * * * * * *,46岁

更才能加,* * * * * * * * * * * * * *,44岁

民才能主,* * * * * * * * * * * * * *,44 #,库的引用

import jieba

import matplotlib as mpl

import matplotlib.pyplot as plt

得到wordcloud import WordCloud

#定义一个空字符串

final =,““

#文件夹位置

时间=filename r" D: \ python \ pra \推荐系统1 - 500. - txt"

,

#打开文件夹,读取内容,并进行分词

with 开放(文件名,& # 39;" # 39;,encoding =, & # 39; utf - 8 # 39;), as f:

for 才能;line 拷贝f.readlines ():

,,,word =, jieba.cut(线)

,,,for 小姐:拷贝词:

,,,,,final =, final +,小姐:+“,“以前 #,图云打印

时间=word_pic WordCloud (font_path =, " # 39; C: \ Windows \ \ simkai.ttf& # 39;字体,width =, 2000年,height =, 1000) .generate(最终)

plt.imshow (word_pic)

#去掉坐标轴

plt.axis(& # 39;从# 39;)

#保存图片到相应文件夹

python plt.savefig (" # 39; D: \ \ pra \ 6. png # 39;)

这篇文章给大家分享的是有关Python jieba中文分词与词频统计的操作案例的内容。小编觉得挺实用的,因此分享给大家做个参考,一起跟随小编过来看看吧。

Python主要应用于:1,网络开发;2、数据科学研究;3,网络爬虫;4、嵌入式应用开发,5日游戏开发;6桌面应用开发。

直接看代码吧:

样本:十九大报告全文

<强>补充:jieba读取txt文档并进行分词,词频统计,输出词云图

代码实现

运行结果