伴随着电商等用户在双11日秒杀之类业务高峰期流量的迅猛增长,对虚拟机网络性能提升的需求日益迫切,25 g网络逐渐成为一种标配。为了解决传统纯软件虚拟交换机方案带来的性能瓶颈,我们在调研了业界主流的智能网卡方案之后,最终决定采用基于OpenvSwitch的开源方案,并成功在公有云落地应用。

相较于传统方案,新的智能网卡方案在整个开关的转发上性能为小包24 mpp,单VF的接收性能达15 mpp,网卡整体性能提升十倍以上。应用于云主机后,可将其网络能力提升至少4倍时延降低3倍,有效解决电商等业务高峰期的稳定性问题。本文将详细讲讲新方案从选型到落地过程中遇到的坑及解决之道,希望能给人以借鉴与启发。

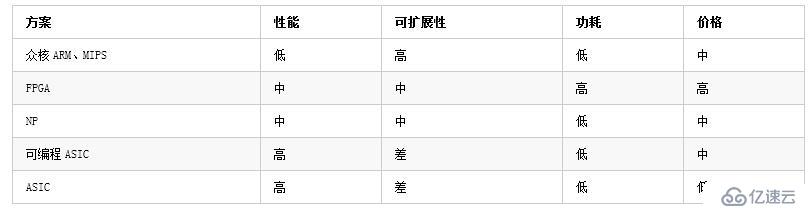

<>强业界主流的智能网卡方案对比

传统的软件虚拟交换机的性能瓶颈,在于其从物理网卡接收报文后,是按照转发逻辑发送vhost给线程,vhost再传递给虚拟机的方式执行,如此一来,vhost的处理能力就成为了影响虚拟机网络性能的关键。

于是,在宿主机上通过25克SmartNIC对网络流量进行卸载成为业界公认的主流方向。现阶段,智能网卡的实现百花齐放,例如:AWS采用基于通用手臂的众核方案,Azure采用基于FPGA的方案,华为云采用基于专用网络处理器(NP)的方案,阿里云采用基于可编程ASIC芯片的方案。就目前来看各个方案各有优劣,并没有特别突出一统天下的方案。