本篇内容主要讲解“Hadoop的安装步骤”,感兴趣的朋友不妨来看看。本文介绍的方法操作简单快捷,实用性强。下面就让小编来带大家学习“Hadoop的安装步骤”吧!

环境:

Ubuntu14.04

Hadoop测试盒框,蜂巢,0.13.1

<强>一。单机模式

1。安装全新的Ubuntu系统,用sudo apt-get更新和sudo apt-get升级更新系统,这步属个人习惯,可以不做。

2。创建hadoop用户组和hadoop帐号:

,,sudo addgroup hadoop

,,sudo adduser小集团hadoop hadoop

3。编辑/etc/sudo文件给hadoop帐号开与根一样的权限,hadoop 所有=(:全部)

4。用hadoop用户登录:苏hadoop

5。确认openssh已经安装如未安装则安装:

,,,,, sudo apt-get安装openssh服务器

,,,, sudo/etc/init.d/ssh开始

6。创建免密码登录,生成私钥和公钥

ssh - keygen rsa - p - t““

7。将公钥追加到authorized_keys中,它用户保存所有允许以当前用户身份登录到ssh客户端用户的公钥内容。

猫~/. ssh/id_rsa。酒吧在祝辞~/. ssh/authorized_keys

8。ssh localhost测试无密码登录。

9。安装java环境(最好安装sunjdk,不要安装openjdk)

,,一。下载最新版的jdk,并解压

,,b。创建安装目录mkdir/usr/lib/jvm

,,c。将解压好的jdk移动到安装目录,如:sudo mv jdk1.7//usr/lib/jvm/java-7-sun

,,d。编辑~/. bashrc以配置java的环境:

,,,,,,,,出口JAVA_HOME=/usr/lib/jvm/java-7-sun

,,,,,,,,出口JRE_HOME=$ {JAVA_HOME}/jre

,,,,,,,,出口CLASSPATH=: $ {JAVA_HOME}/lib: $ {JRE_HOME}/lib

,,,,,导出路径=$ {JAVA_HOME}/bin: PATH 美元;

,,~/e来源。bashrc使(配置生效,env查看结果,

,,f。配置默认程序

,,sudo update-alternatives——才能安装java/usr/lib/jvm/java-7-sun/bin/java/usr/bin/java 300,

,,,sudo update-alternatives——安装/usr/bin/javac javac/usr/lib/jvm/java-7-sun/bin/javac 300,

,,,sudo update-alternatives——配置java,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,sudo update-alternatives——配置javac

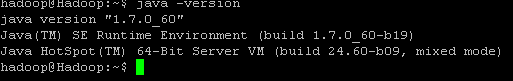

,g。java版java - version; avac - version查看本号是否正确。

(Ps:之前我装的是java1.8版本,但是在后面编译Hadoop的时候保存了,然后果断换成1.7版本,一切正常)

10。下载hadoop最新版,http://mirror.bit.edu.cn/apache/hadoop/common/ ,并解压;

11。创建hadoop安装目录sudo mkdir/usr/local/hadoop,将解压后的hadoop文件夹移过去sudo mv。/hadoop-2.4.0/*/usr/local/hadoop;修改hadoop安装目录权限,sudo chmod 774/usr/local/hadoop

12。配置haoop环境变量、vi ~/.bashrc

14。测试

单机模式安装完成,下面通过执行hadoop自带实例WordCount验证是否安装成功

,,,,/usr/地方/hadoop路径下创建输入文件夹,,,,

mkdir输入,,,,拷贝固定到input ,,,

cp README。三种输入

,,,,执行WordCount

,,,, bin/hadoop jar/hadoop/mapreduce/分享/hadoop-mapreduce-examples-2.4.0-sources来源。jar org.apache.hadoop.examples。WordCount输入输出

至此,单机版配置完成,其实还是很简单的。

<强>二。伪分布式

15。

设定* xml

这里需要设定3个文件:core-site.xml, hdfs-site.xml, mapred-site.xml,都在/usr/地方/Hadoop/conf目录下

core-site.xml:,Hadoop核心的配置项,例如HDFS和MapReduce常用的I/O设置等。

hdfs-site.xml:,Hadoop守护进程的配置项,包括namenode,辅助namenode和datanode等。

mapred-site。xml: MapReduce守护进程的配置项,包括jobtracker和tasktracker又是;,

首先在hadoop目录下新建几个文件夹

~/hadoop美元mkdir tmp

~/hadoop美元mkdir hdfs

~/hadoop mkdir hdfs美元/名称

~/hadoop mkdir hdfs美元/数据

编辑配置文件:

<强> core-site.xml:

& lt; configuration>

,,& lt; property>

,,,,& lt; name> fs.default.name

,,,,& lt; value> hdfs://localhost: 9000 & lt;/value>

,,& lt;/property>

,,& lt; property>

,,,,& lt; name> hadoop.tmp.dir

,,,,& lt; value>/usr/地方/hadoop/tmp

,,& lt;/property>

& lt;/configuration>

<强> hdfs-site.xml:

& lt; configuration>

,,& lt; property>

,,,,& lt; name> dfs.replication

,,,,& lt; value> 1 & lt;/value>

,,& lt;/property>

,,& lt; property>

,,,,& lt; name> dfs.name.dir

,,,,& lt; value>/usr/地方/hadoop/hdfs/name

,,& lt;/property>

,,null