这期内容当中小编将会给大家带来有关Elasticsearch + Fluentd +卡夫卡怎么搭建分布式日志系统,文章内容丰富且以专业的角度为大家分析和叙述,阅读完这篇文章希望大家可以有所收获。

前言

由于logstash内存占用较大,灵活性相对没那么好,麋鹿正在被EFK逐步替代。其中本文所讲的EFK是Elasticsearch + Fluentd + Kfka,实际上K应该是Kibana用于日志的展示,这一块不做演示,本文只讲述数据的采集流程。

前提

码头工人

<李>docker-compose

<李>apache卡夫卡服务

架构

数据采集流程

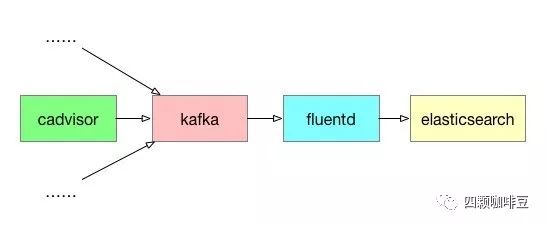

数据的产生使用cadvisor采集容器的监控数据并将数据传输到卡夫卡。

数据的传输链路是这样:Cadvospr→卡夫卡→Fluentd→elasticsearch ,

每一个服务都可以横向扩展,添加服务到日志系统中。

配置文件

docker-compose。yml

<代码>版本:“3.7“

服务:,elasticsearch:,图片:elasticsearch: 7.5.1,环境:,——发现。类型=单节点,#使用单机模式启动,港口:,,- 9200:9200 cadvisor:,,图片:谷歌/cadvisor,,命令:-storage_driver=卡夫卡-storage_driver_kafka_broker_list=192.168.1.60:9092(卡夫卡服务IP:端口)-storage_driver_kafka_topic=kafeidou,depends_on:大敌;,,- elasticsearch fluentd:,图片:lypgcs/fluentd-es-kafka: v1.3.2,卷:——。/:/etc/流利,,-/var/log/fluentd:/var/log/fluentd

其中:

cadvisor产生的数据会传输到192.168.1.60这台机器的卡夫卡服务,主题为kafeidou

<李>elasticsearch指定为单机模式启动(<代码> discovery.type=单节点>

fluent.conf

<代码> # & lt; source>

#,输入http

#,端口8888

# & lt;/source>

& lt; source>

, @type卡夫卡

,经纪人192.168.1.60:9092

, json格式

, & lt; topic>

,主题的大敌;,kafeidou

, & lt;/topic>

& lt;/source>

& lt;匹配* *在

,

@type副本#,& lt; store>

#,@type stdout

#, & lt;/store>

, & lt; store>

, @type elasticsearch

,主机192.168.1.60

,

9200端口,logstash_format真正

, # target_index_key machine_name

, logstash_prefix kafeidou

, logstash_dateformat % y % m。% d

, flush_interval 10 s

, & lt;/store>

& lt;/match>

其中:

类型为复制的插件是为了能够将fluentd接收到的数据复制一份,是为了方便调试,将数据打印在控制台或者存储到文件中,这个配置文件默认关闭了,只提供必要的es输出插件。

需要时可以将<代码> @type stdout> <李>

输入源也配置了一个http的输入配置,默认关闭,也是用于调试,往fluentd放入数据。

可以在linux上执行下面这条命令:

<代码> curl - i - x POST - d & # 39; json={“action":“write",“user":“kafeidou"} & # 39;http://localhost: 8888/mytag

<李> target_index_key参数,这个参数是将数据中的某个字段对应的值作为es的索引,例如这个配置文件用的是machine_name这个字段内的值作为es的索引。

开始部署

在包含docker-compose.yml文件和流利。参看文件的目录下执行:

<代码> docker-compose起来- d

在查看所有容器都正常工作之后可以查看一下elasticsearch是否生成了预期中的数据作为验证,这里使用查看es的索引是否有生成以及数据数量来验证:

<代码> bash:——:未找到命令

(root@master卡夫卡)# curl http://192.168.1.60:9200 _cat/指标吗?v

健康状况指数,,,,,,,,,,,,,,,uuid大敌;,,,,,,,,革命制度党代表文档。计数docs.deleted商店。pri.store大小。大小

黄色开放,55 a4a25feff6,,,,,,,,,,,,Fz_5v3suRSasX_Olsp-4tA,1,1,,,1,,,,,,0,4 kb大敌;,,,,,4 kb

也可以直接在浏览器输入<代码> http://192.168.1.60:9200 _cat/指数? v>

可以看到我这里是用了machine_name这个字段作为索引值,查询的结果是生成了一个叫<代码> 55 a4a25feff6> docs.count>

到目前为止<代码>卡夫卡→fluentd→es 这样一个日志收集流程就搭建完成了。

当然了,架构不是固定的。也可以使用