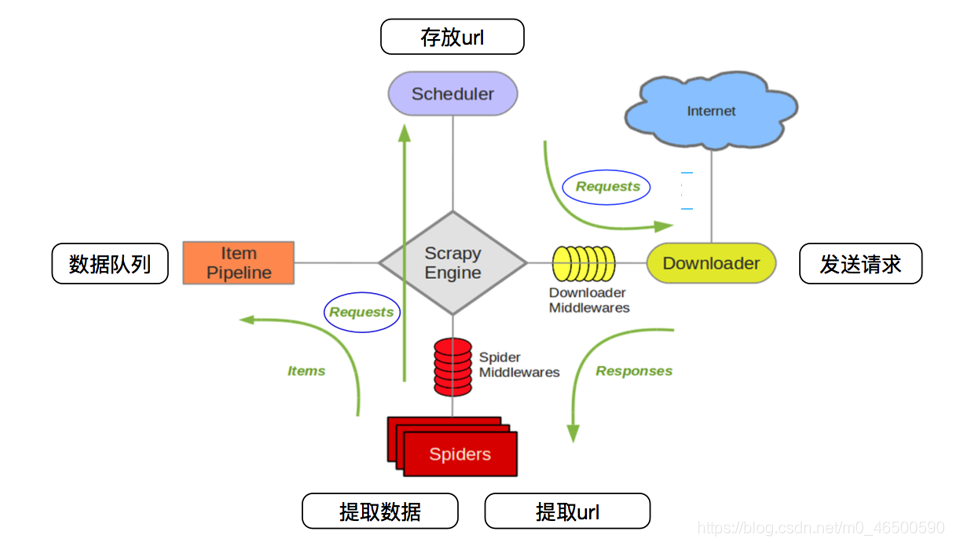

介绍

<李> USER_AGENT =, & # 39; Mozilla/5.0, (Windows NT 10.0;, Win64;, x64), AppleWebKit/537.36, (KHTML, like 壁虎),Chrome/88.0.4324.150 Safari/537.36, Edg/88.0.705.68& # 39; ROBOTSTXT_OBEY =,假 LOG_LEVEL=& # 39;错误# 39;,==,scrapy crawl spiderName ——nolog//二者是等价的,当然还是推荐使用前者

这篇文章将为大家详细讲解有关如何在python中使用scrapy模块,文章内容质量较高,因此小编分享给大家做个参考,希望大家阅读完这篇文章后对相关知识有一定的了解。

pip install scrapy

pip install scrapy

2。<强> windows系统:

先安装轮:<代码> pip安装轮

<李>下载扭曲:下载地址

<李>安装扭曲:<代码> pip安装扭? 17.1.0 ? cp36 ? cp36m ? win_amd64。whl(记得带后缀)

pip install pywin32

pip install scrapy

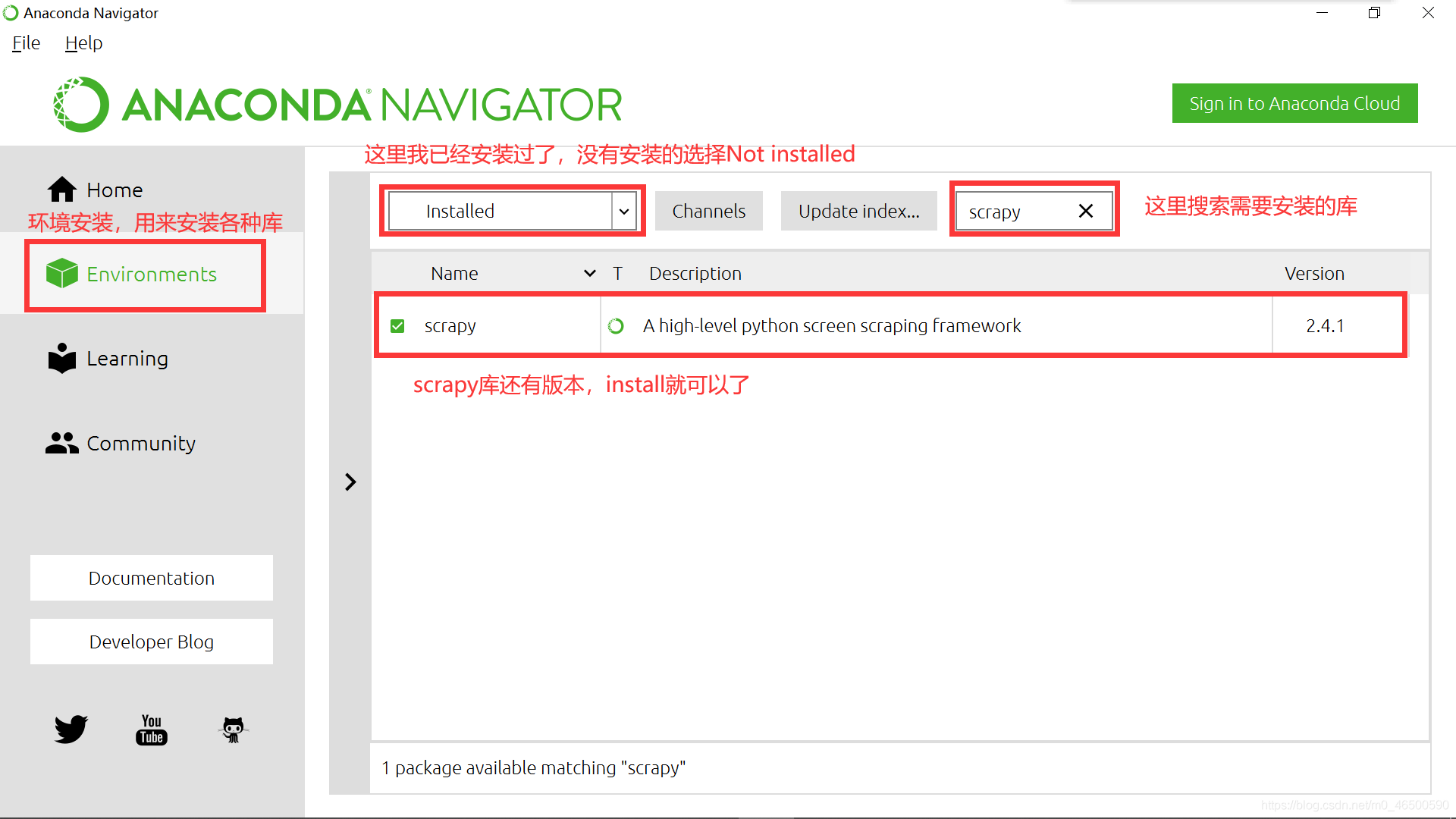

3.Anaconda(推荐)

在我一开始学python使用的就是python3.8,在安装各种库的时候,总会有各种报错,真的有点让人奔溃。Anaconda在安装过程中就会安装一些常用的库,其次,当我们想要安装其他库时也很方便。当然大家也可以选择安装其他的一些软件,

2.2 scrapy使用流程

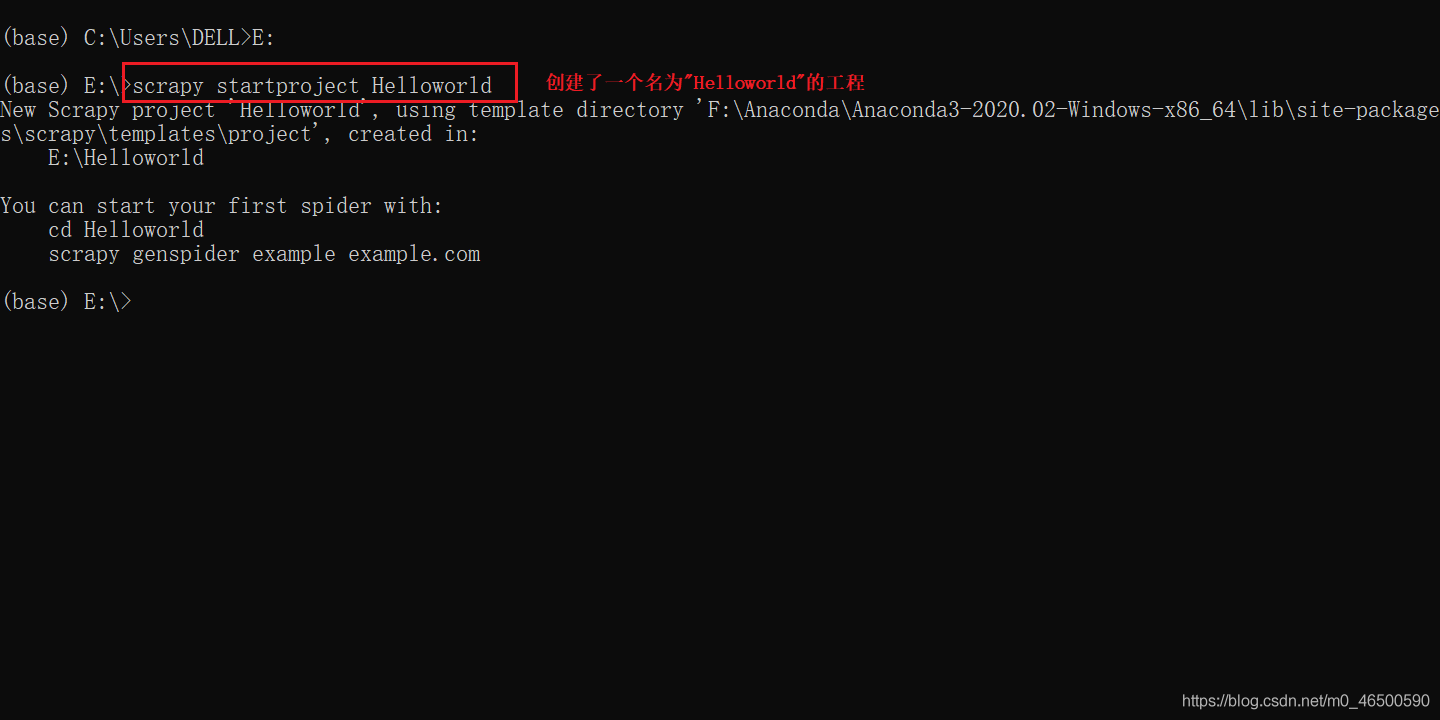

这里默认大家已经安装好scrapy库,大家要记得要在命令行里输入以下命令啊。(我使用的anaconda的命令行)

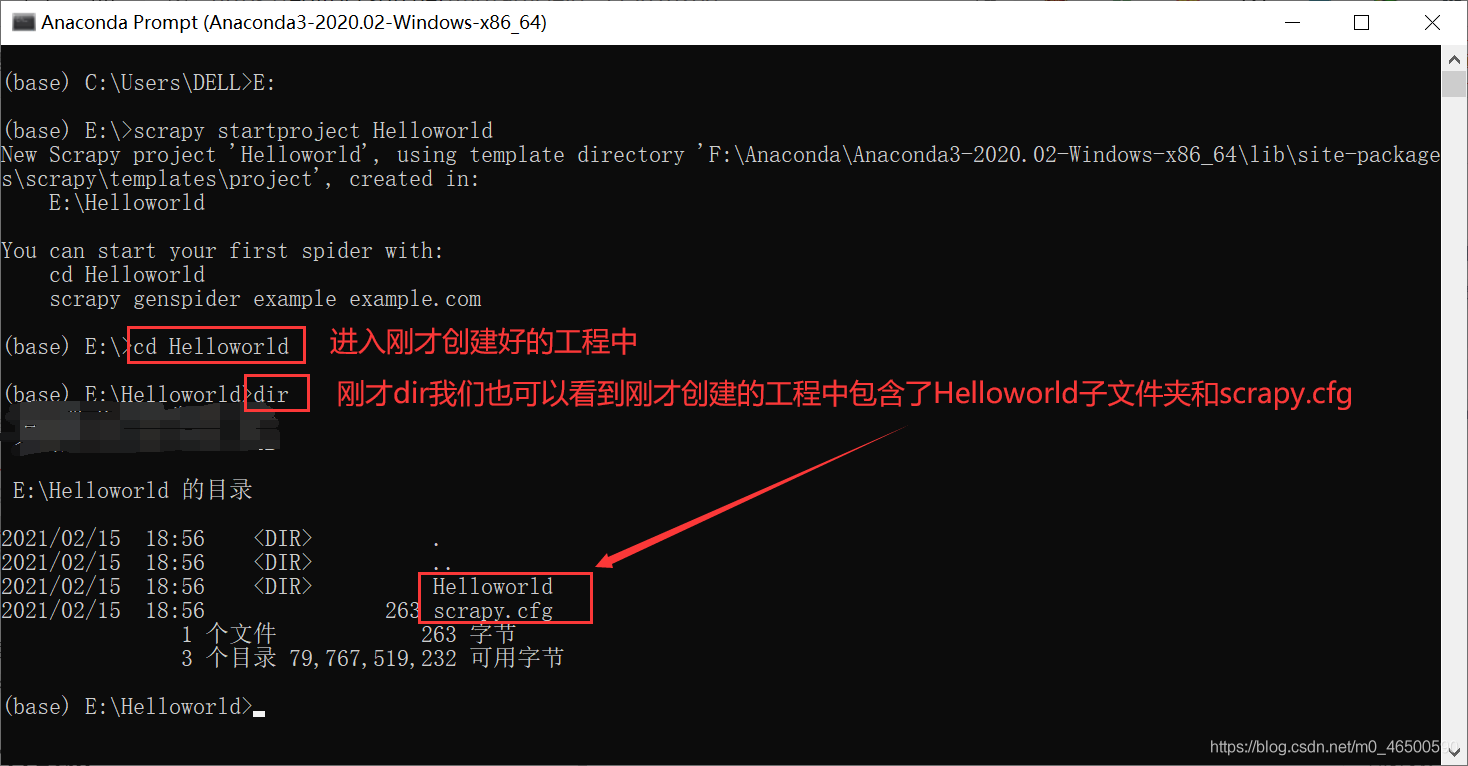

创建工程

scrapy startproject projectName

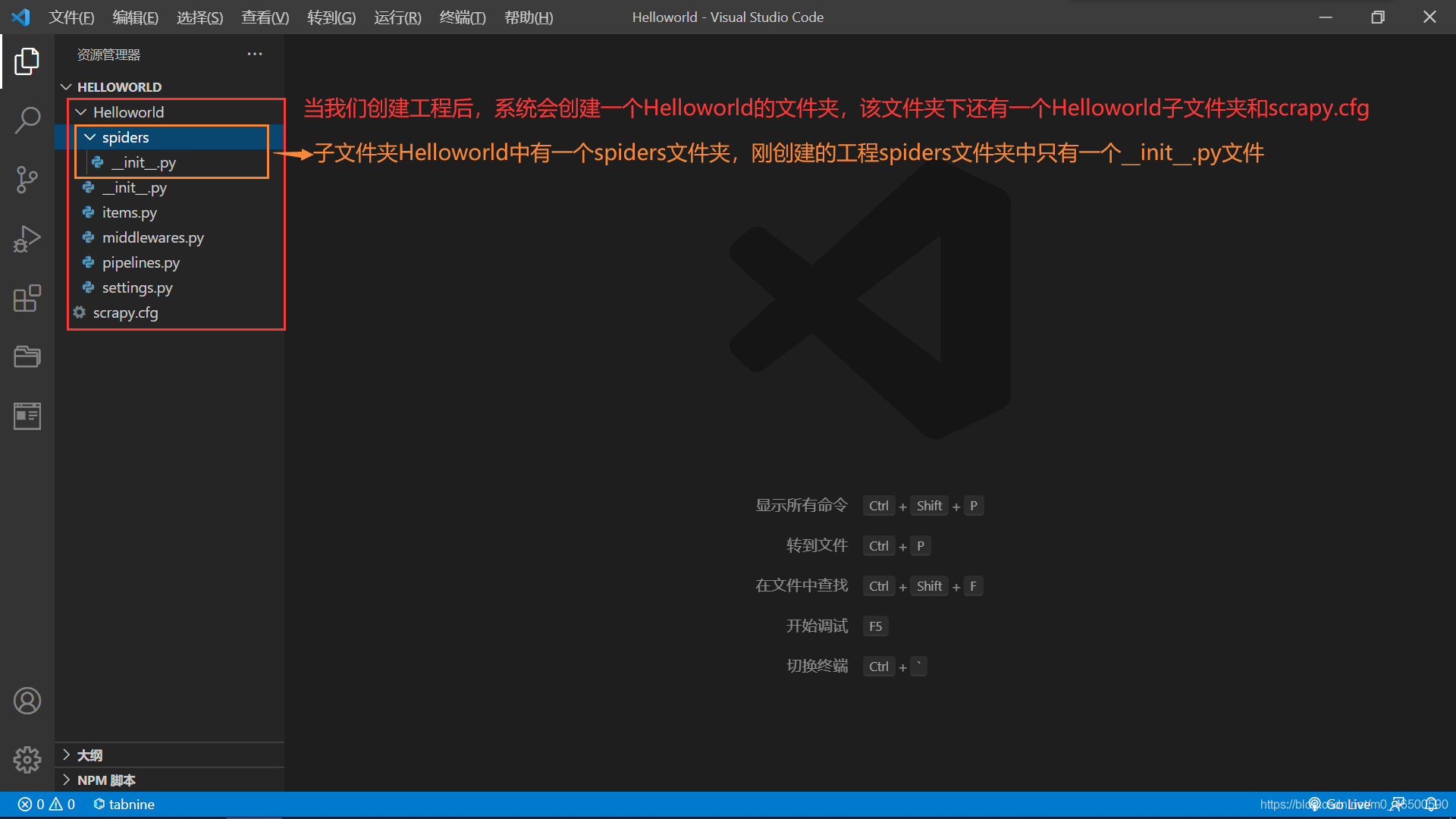

进入工程目录:这里一定要进入到刚才创建好的目录中

cd projectName

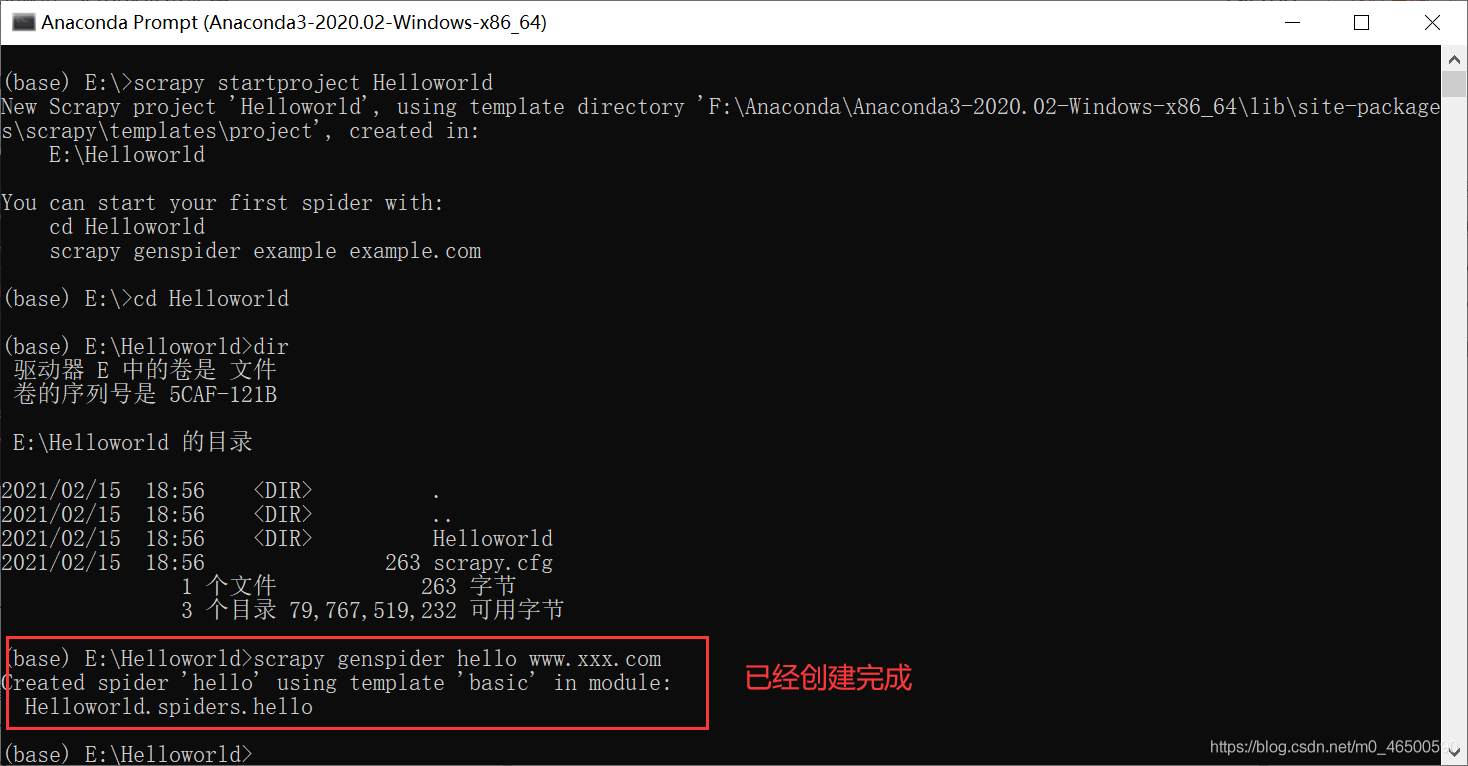

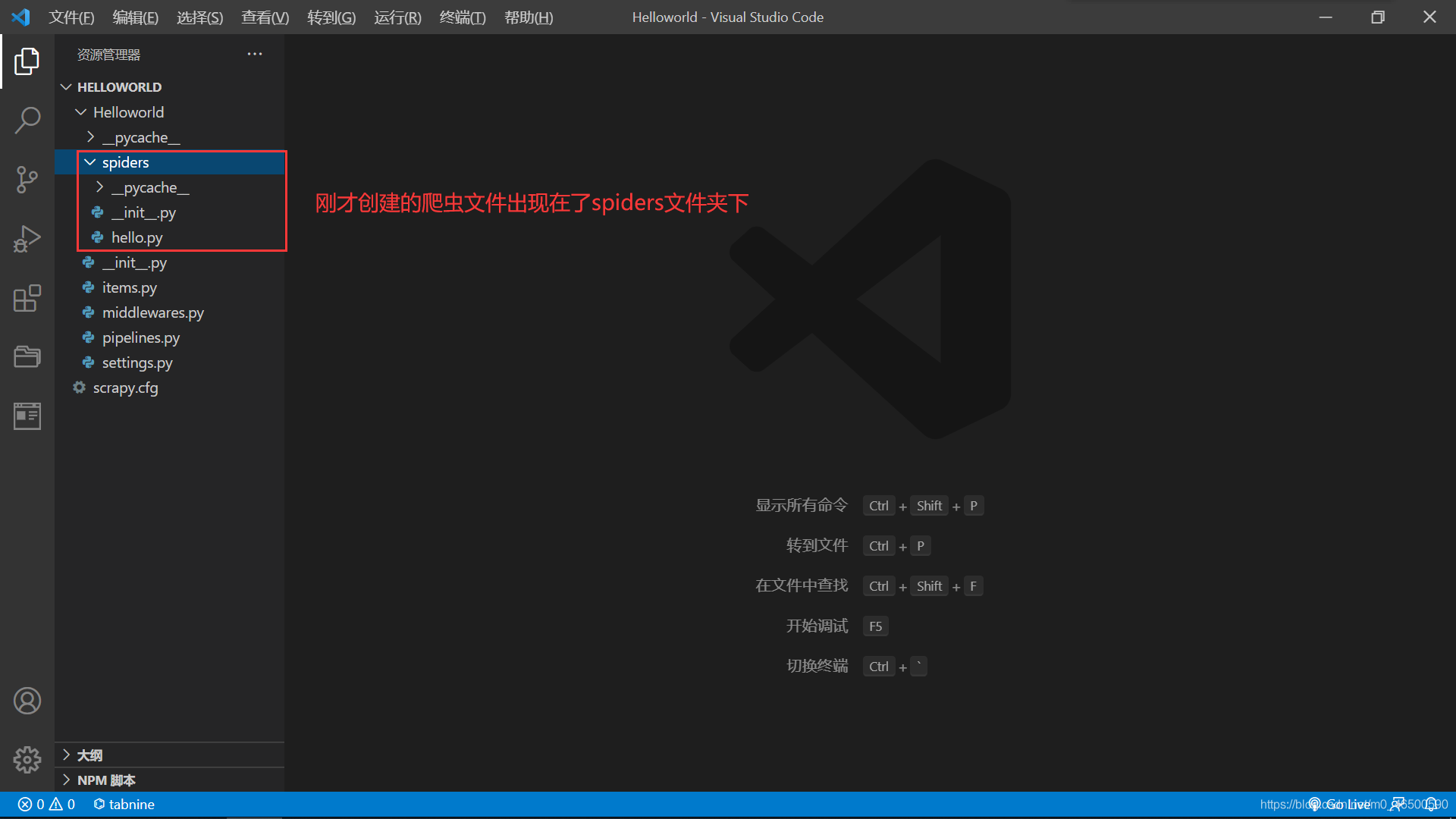

创建爬虫文件:创建的爬虫文件会出现在之前创建好的spiders文件夹下

scrapy genspider spiderName www.xxx.com

编写相关代码

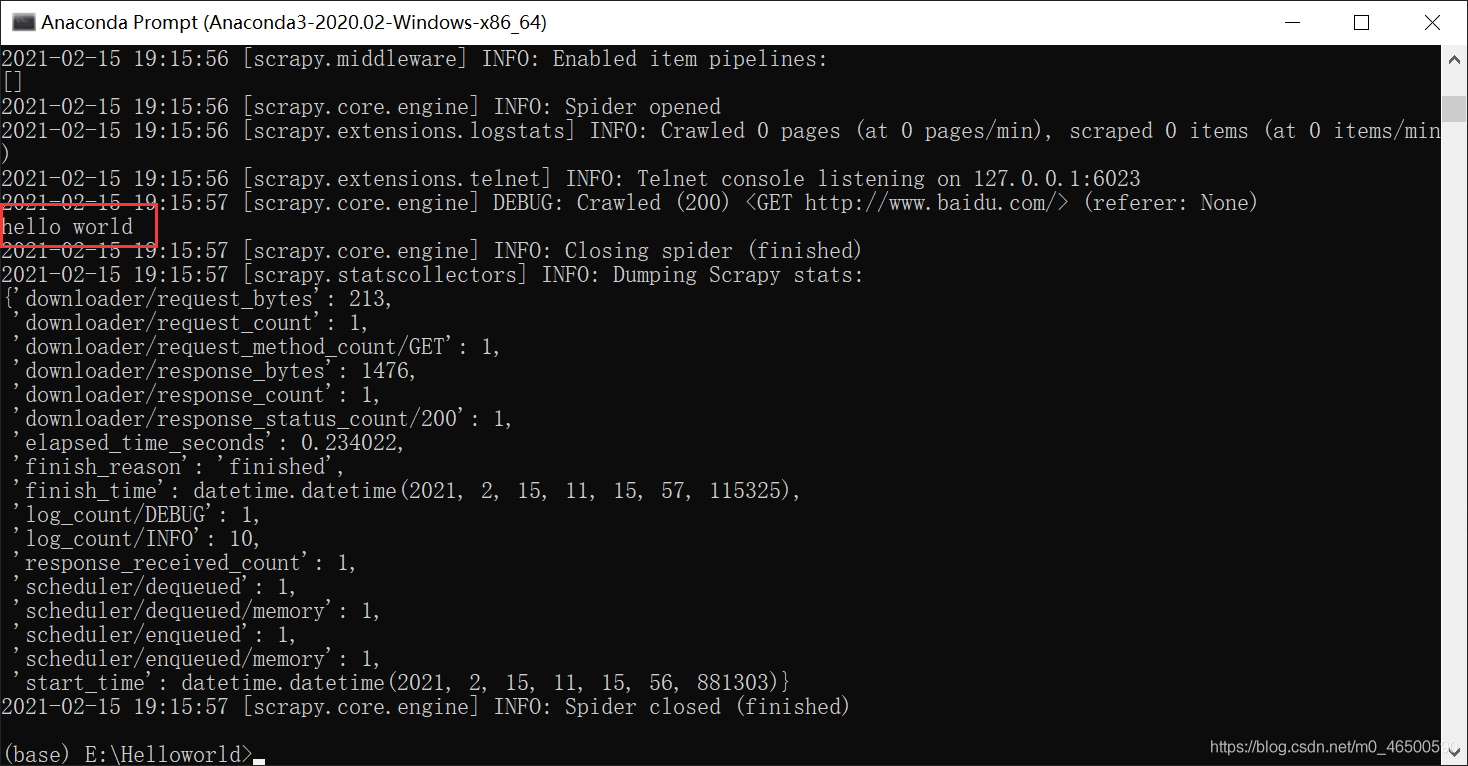

执行爬虫文件

scrapy crawl spiderName

2.3 文件解析

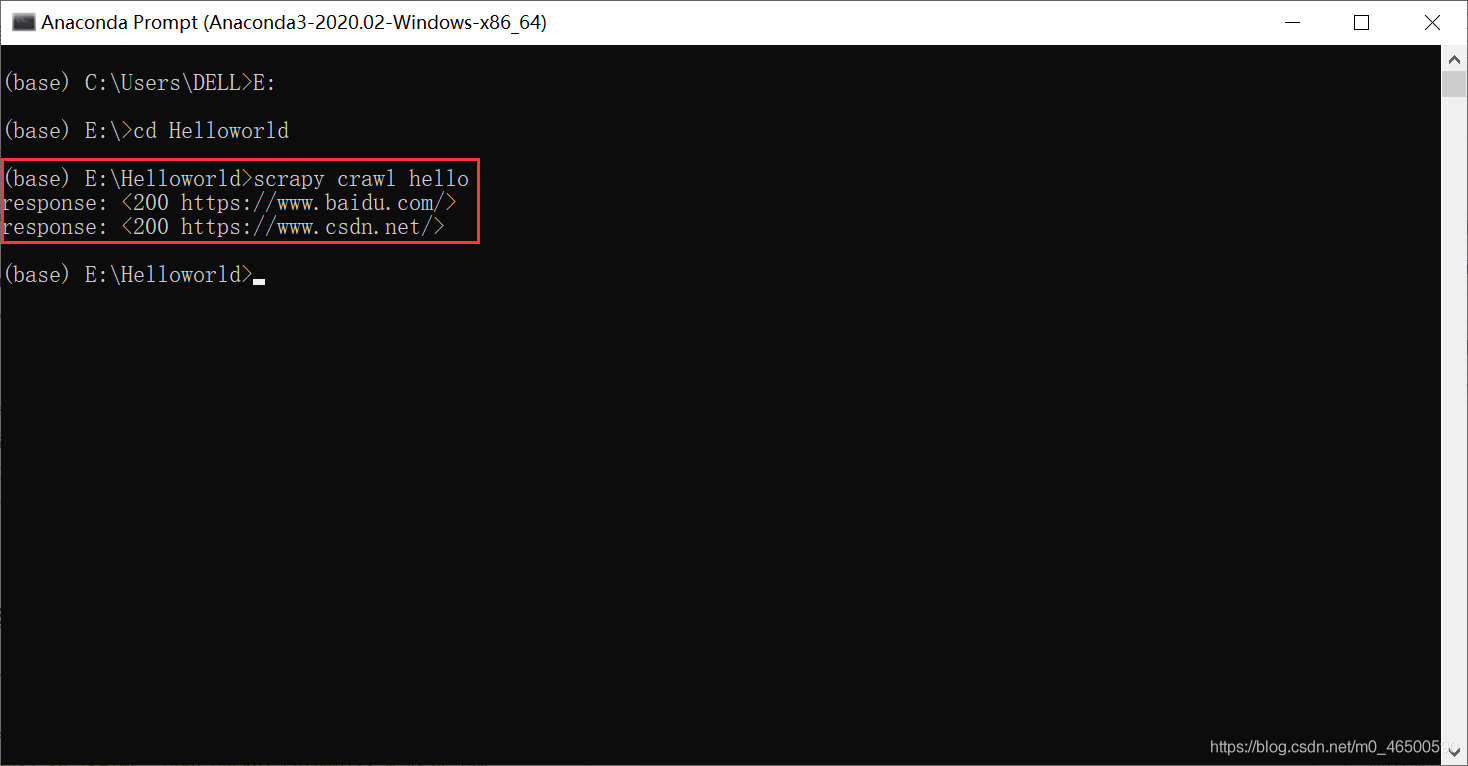

import scrapy class HelloSpider (scrapy.Spider):=,name & # 39;你好# 39;,#,爬虫名称 ,#允许的域名:限定start_urls列表当中哪些url可以进行请求的发送 ,#通常情况下我们不会使用 ,# allowed_domains =, (& # 39; www.baidu.com& # 39;), ,#起始的url列表:scrapy会自动对start_urls列表中的每一个url发起请求 ,#我们可以手动添加我们需要访问的url=,start_urls [& # 39; https://www.baidu.com/& # 39; & # 39; https://www.csdn.net/& # 39;】 ,def 解析(自我,,反应):,#,当scrapy自动向start_urls中的每一个url发起请求后,会将响应对象保存在响应对象中 ,#代码一般是在解析方法中写 ,打印(“回应:“、响应)

2.4设置。py一些常见的设置

<强>相当于中请求的头参数中的用户代理

<强>可以忽略或者不遵守机器人协议

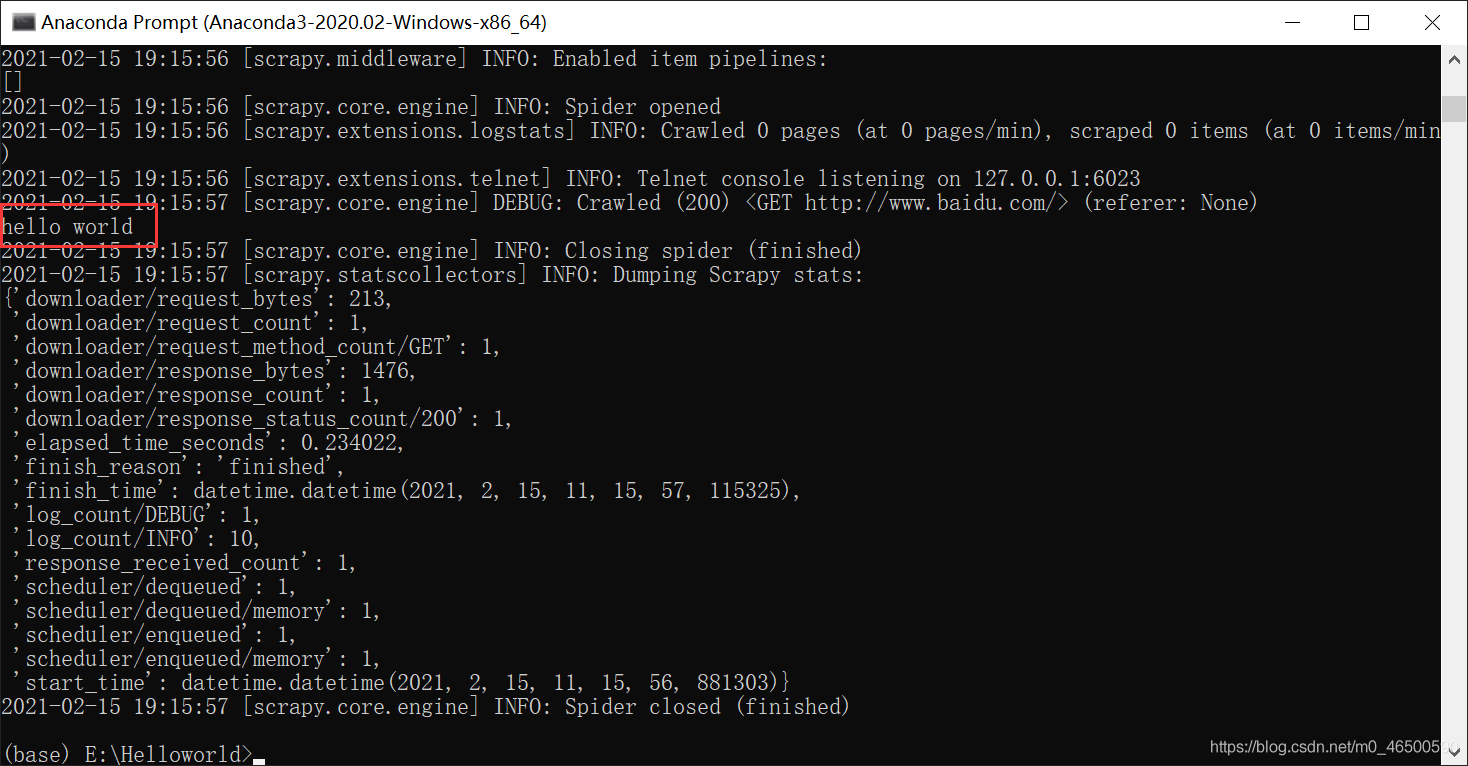

<强>只有程序出现错误的情况下,才显示日志文件,程序正常执行时只会输出我们想要的结果

未加<代码> LOG_LEVEL=& # 39;错误# 39;

加