Apache火花是一个新兴的大数据处理通用引擎,提供了分布式的内存抽象.Spark最大的特点就是快,可比Hadoop MapReduce的处理速度快100倍。本文没有使用一台电脑上构建多个虚拟机的方法来模拟集群,而是使用三台电脑来搭建一个小型分布式集群环境安装。

本教程采用Spark2.0以上版本(比如Spark2.0.2, Spark2.1.0等)搭建集群,同样适用于搭建Spark1.6.2集群。

火花分布式集群的安装环境,需要事先配置好Hadoop的分布式集群环境。

这里采用3台机器(节点)作为实例来演示如何搭建火花集群,其中1台机器(节点)作为大师节点,另外两台机器(节点)作为奴隶节点(即作为工人节点),主机名分别为Slave01和Slave02。

在主节点机器上,访问火花官方下载地址,按照如下图下载。

下载完成后,执行如下命令:

在mst节点主机的终端中执行如下命令:

在. bashrc添加如下配置:

执行如下命令使得配置立即生效:

在主节点主机上进行如下操作:

配置奴隶文件

将奴隶。模板拷贝到奴隶

奴隶文件设置工人节点。编辑奴隶内容,把默认内容localhost替换成如下内容:

配置spark-env。上海文件

将spark-env.sh。模板拷贝到spark-env。sh

编辑spark-env.sh,添加如下内容:

SPARK_MASTER_IP指定火花集群主节点的IP地址;

配置好后,将主主机上的/usr/地方/火花文件夹复制到各个节点上。在主主机上执行如下命令:

在slave01, slave02节点上分别执行下面同样的操作:

<>强启动Hadoop集群

启动火花集群前,要先启动Hadoop集群。在主节点主机上运行如下命令:

<>强启动火花集群

1。启动主节点

在主节点主机上运行如下命令:

在主节点上运行jps命令,可以看到多了个主进程:

2。启动所有奴隶节点

在主节点主机上运行如下命令:

分别在slave01, slave02节点上运行jps命令,可以看到多了个工人进程

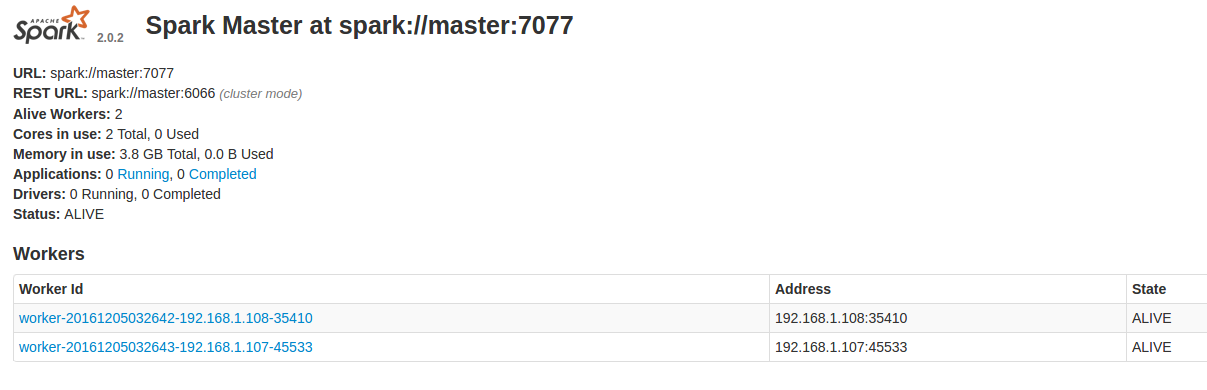

3。在浏览器上查看火花独立集群管理器的集群信息