自动化测试框架龙猫是由蚂蚁金服终端工程技术部实验平台技术组自主研发的一套自动化测试框架、支持, 、 、 、 、 、 ,等移动端自动化测试场景。

为了确保蚂蚁金服移动测试平台在集群环境下能够稳定,高效运行自动化任务,并灵活快速支持多场景域内业务,龙猫经历了从0到1,从1到2,并逐步演进到目前支撑阿里域内10 + BU日常自动化测试及结合移动开发平台美国电影协会对外输出,成为集团内使用面最广、性能最为稳定的自动化测试框架之一。

本文将围绕龙猫一路踩坑,迭代完善成熟的过程,从沉淀总结的一些方法论和解决方案展开分享:

-

<李>

李

<李>

李

<李>

李

<李>

李

<李>

李

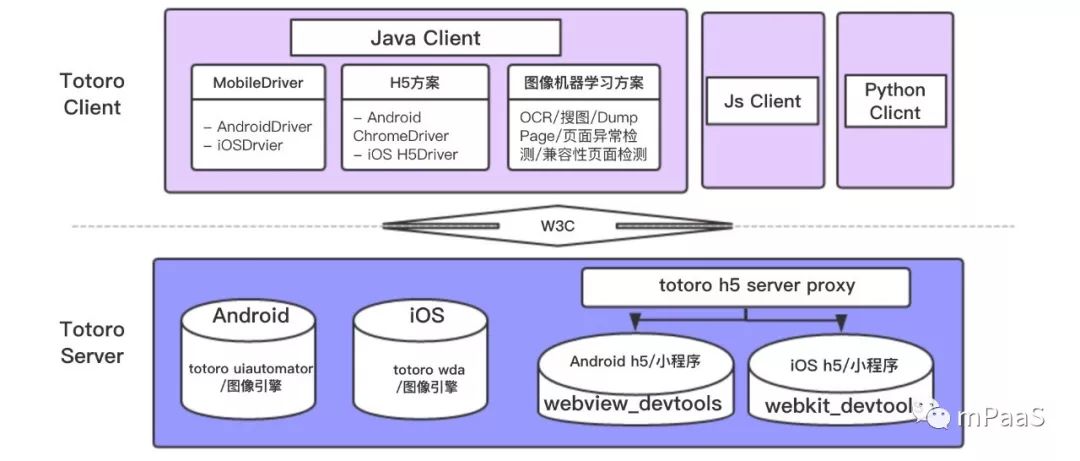

龙猫C/S架构模型设计

蚂蚁金服移动测试平台最开始引用了Appium开源解决方案,但由于其部署复杂,接口不稳定,设备掉线,多层服务链路,社区维护不够迅速等种种问题,综合评估业内类似框架都有共性的痛点,因此我们决定重新设计一套适合云测集群环境,满足域内不同业务需求快速迭代更新的解决方案。

基于已有的痛点,我们认为龙猫从设计上需要满足”调用链路尽可能短”,“项目结构尽可能简单透明”等特点,从而确保测试链路上的不稳定因素尽可能少,同时,综合考虑异常情况下,我们需要能够快速定位问题,并具备一定的自修复能力。结合业内多个框架普遍采用三层或多层的设计,龙猫最终被设计成了C/S模型的两层架构。