本篇内容主要讲解”如何用mapreduce处理数据倾斜问题”,感兴趣的朋友不妨来看看。本文介绍的方法操作简单快捷,实用性强。下面就让小编来带大家学习”如何用mapreduce处理数据倾斜问题”吧!

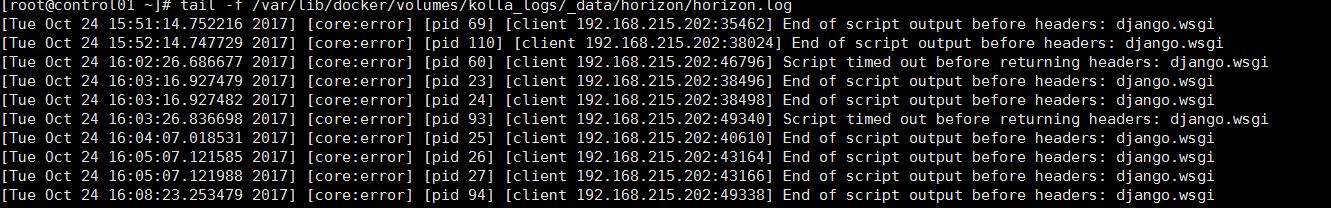

<强> map/reduce程序执行时,减少节点大部分执行完毕,但是有一个或者几个减少

节点运行很慢,导致整个程序的处理时间很长,这是因为某一个关键的条数比其他关键多

很多(有时是百倍或者千倍之多),这条关键所在的减少节点所处理的数据量比其他节

点就大很多,从而导致某几个节点迟迟运行不完,此称之为数据倾斜。

解决方法:

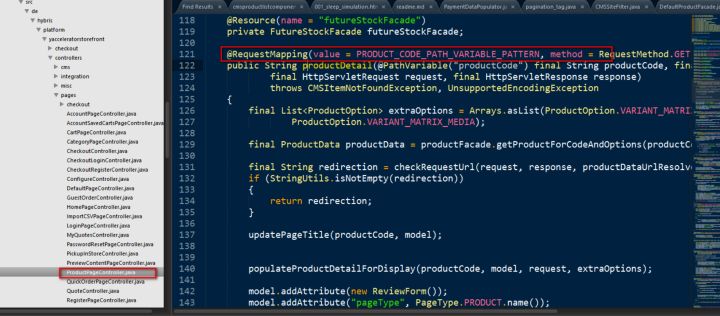

(1)设置一个散列份数N,用来对条数众多的关键进行打散。

(2)对有多条重复关键的那份数据进行处理:从1到N将数字加在关键的后面作为新钥匙,

如果需要和另一份数据关联的话,则要重写比较类和分发类。如此实现多条关键的平均分发。

(3)上一步之后,钥匙被平均分散到很多不同的减少节点。如果需要和其他数据关联,

为了保证每个减少节点上都有关联的关键,对另一份单一关键的数据进行处理:循环的

从1到N将数字加在关键的后面作为新键

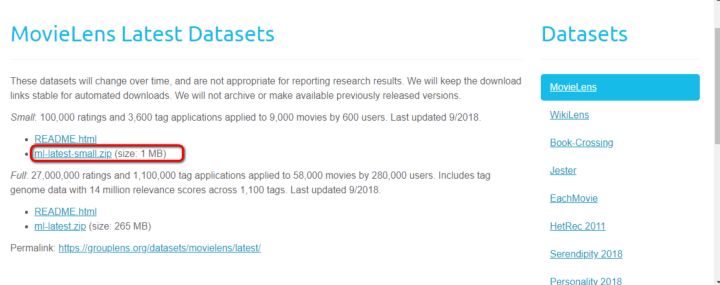

用上述的方法虽然可以解决数据倾斜,但是当关联的数据量巨大时,如果成倍的增长某

份数据,会导致减少洗牌的数据量变的巨大,得不偿失,从而无法解决运行时间慢的

问题。

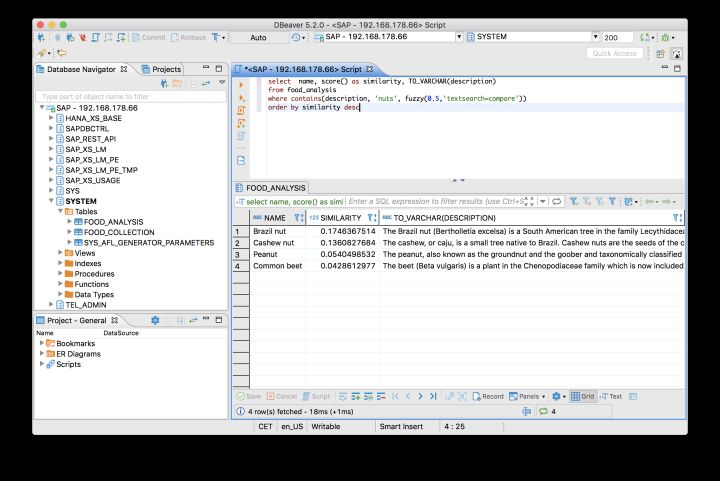

在两份数据中找共同点,比如两份数据里除了关联的字段以外,还有另外相同含义的字段,

如果这个字段在所中有日志的重复率比较小,则可以用这个字段作为计算散列的值,如果

是数字,可以用来模哈希的份数,如果是字符可以用hashcode来模哈希的份数(当然数

字为了避免落到同一个减少上的数据过多,也可以用hashcode),这样如果这个字段

的值分布足够平均的话,就可以解决上述的问题。

解决方法:1。增加减少的jvm内存2。增加个减少数

到此,相信大家对“如何用mapreduce处理数据倾斜问题”有了更深的了解,不妨来实际操作一番吧!这里是网站,更多相关内容可以进入相关频道进行查询,关注我们,继续学习!