1。HDFS的壳操作

<代码> hadoop版本//查看版本 hadoop fs -appendToFile src (Linux中的文件)桌子(hdfs目录下的文件)//追加 hadoop fs猫文件(hdfs目录下的文件)//查看文件内容 Hadoop fs多边形文件(hdfs目录下的文件)//查看文件末尾1 kb的数据 hadoop fs校验和文件(hdfs目录下的文件)//校验当前文件是否正确 hadoop fs -copyFromLocal src桌子//从本地复制文件到HDFS hadoop fs -copyToLocal dest src//从hdfs复制文件到本地 hadoop fs计算路径//对目录内容做计数 hadoop fs找到路径//查看某个hdfs目录中是否相应的文件 hadoop fs -getmerge src//合不在座位上并下载 hadoop fs - ls路径//列的表 hadoop fs——文件(本地)桌子(hdfs)//将本地文件上传到hdfs hadoop fs -setrep num文件//设置hdfs系统中的某个文件的副本数(只能是hdfs中已上传的文件) hadoop fs -setrep - r//num文件设置hdfs系统中的目录下的所有文件的副本数 hadoop fs语境压缩文件//查看hdfs中的压缩文件 hadoop fs截断dir//清空hdfs目录 hdfs getconf -confkey(例子)(配置文件的名称)//查看相应的配置的值

2。HDFS的API操作

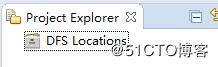

1) eclipse中的hdfs的开发环境搭建:

-

<李>下载一个新版的eclipse,将自己集成的hadoop-eclipse-plugin-2.7.4.jar放入eclipse的安装目录中的…\ eclipse-hadoop \ plugins中。

插件下载地址:http://down.51cto.com/data/2457877

然后打开eclipse:

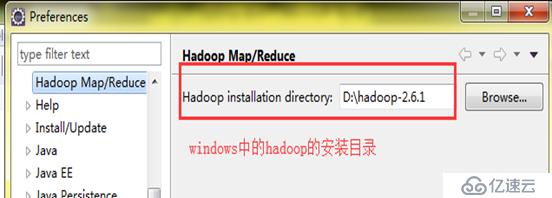

<李>窗口平台使用hadoop:

<李>窗口平台使用hadoop:

-

<李>在windows下配置hadoop的环境变量,将hadoop的解压包放置一个位置,然后加入:HADOOP_HOME: . ./hadoop2.7.4/,在路径中% HADOOP_HOME: %/bin,

hadoop.dll, winutils.exe下载地址:http://down.51cto.com/data/2457878 <李>将hadoop。dll放入c: \ windows \ system32系统中李 <李>将winutils。exe,放入hadoop的本目录下李 <李>将eclipse集成hadoop

李

李2)添加hadoop依赖包的三种方式:

-

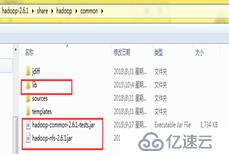

<李>在项目中创建一个文件夹,然后将所有需要依赖的jar拷贝到这个目录,右击添加构建路径将jar导入项目李

<李>创建一个用户的图书馆,在本地将相应的jar包导入到项目中:

? ? <强>文件系统类的介绍:

获取文件系统对象:

<代码>//以这种方式获取的fs对象是本地的文件系统的对象,如果在windows下就是windows的对象 配置配置=new配置(); 文件系统fs=FileSystem.get(设计);//能加载自己集群的文件系统对象 conf.set (“fs.defaultFS”、“hdfs://hadoop01:9000”);HDFS的外壳和API操作