介绍 import urllib.request

import 时间

#,使用build_opener()是为了让python程序模仿浏览器进行访问

时间=opener urllib.request.build_opener ()

opener.addheaders =,((& # 39;用户代理# 39;,,& # 39;Mozilla/5.0 & # 39;))

#,专刷某个页面

打印(& # 39;开始刷了哦:& # 39;)

时间=tempUrl & # 39; https://blog.csdn.net/Lin_QC/article/details/88966839& # 39;

for j 拷贝范围(2000):

尝试才能:

,,,opener.open (tempUrl)

,,,time . sleep (7)

,,,print (& # 39; % d % & # 39;, %, (j, tempUrl))

except 才能;urllib.error.HTTPError:

,,,print (& # 39; urllib.error.HTTPError& # 39;)

,,,time . sleep (1)

except 才能;urllib.error.URLError:

,,,print (& # 39; urllib.error.URLError& # 39;)

,,,time . sleep (1) import urllib2

import BeautifulSoup

时间=User_Agent & # 39; Mozilla/5.0, (Windows NT 6.3;, WOW64;,房车:43.0),壁虎/20100101,Firefox/43.0 & # 39;

header =, {}

头(& # 39;用户代理# 39;],=User_Agent

时间=url & # 39; https://www.xicidaili.com/wt/1& # 39;

时间=req urllib2.Request (url,头=头)

时间=res urllib2.urlopen(点播).read ()

时间=soup BeautifulSoup.BeautifulSoup (res)

时间=ips soup.findAll (& # 39; tr # 39;)

f =,开放(“proxy",,“w")

for x 拷贝范围(len (ips)):

ip 才能=,ips [x]

时间=tds 才能;ip.findAll (“td")

ip_temp 才能=,tds [1] .contents [0] +“,“+ tds [2] .contents [0] +“\ n"

print 才能tds [1] .contents [0] +“\ t" + tds [2] .contents [0]

f.write才能(ip_temp) import urllib2

import 套接字

import 时间

import 随机

socket.setdefaulttimeout (3)

user_agent_list =, (

& # 39;才能Mozilla/5.0, (Windows NT 6.1;, WOW64), AppleWebKit/537.36, (KHTML, like 壁虎),& # 39;

,,,,,,,,,,& # 39;Chrome/45.0.2454.85 Safari/537.36, 115浏览器/6.0.3& # 39;

& # 39;才能Mozilla/5.0,(麦金塔电脑,,你,,Intel Mac OS X 10 _6_8;, en - us), AppleWebKit/534.50, (KHTML, like 壁虎),版本/5.1,Safari/534.50 & # 39;

& # 39;才能Mozilla/5.0, (Windows;,你,,Windows NT 6.1;, en - us), AppleWebKit/534.50, (KHTML, like 壁虎),版本/5.1,Safari/534.50 & # 39;

& # 39;才能Mozilla/4.0,(兼容;,MSIE 8.0;, Windows NT 6.0;,三叉戟/4.0)& # 39;,

& # 39;才能Mozilla/4.0,(兼容;,MSIE 7.0;, Windows NT 6.0) & # 39;,

& # 39;才能Mozilla/5.0, (Windows NT 6.1;,房车:2.0.1),壁虎/20100101,Firefox/4.0.1 # 39;

& # 39;才能歌剧/9.80,(Windows NT 6.1;, U;, en),转眼间/2.8.131 版本/11.11 & # 39;

& # 39;才能Mozilla/5.0, (Macintosh;, Intel Mac OS X 10 _7_0), AppleWebKit/535.11, (KHTML, like 壁虎),Chrome/17.0.963.56 Safari/535.11 & # 39;

& # 39;才能Mozilla/4.0,(兼容;,MSIE 7.0;, Windows NT 5.1;,三叉戟/4.0;,SE 2. x MetaSr 1.0;, SE 2. x MetaSr 1.0;, .NET CLR 2.0.50727;, SE 2. x MetaSr 1.0) & # 39;,

& # 39;才能Mozilla/5.0,(兼容;,MSIE 9.0;, Windows NT 6.1;,三叉戟/5.0 & # 39;,

& # 39;才能Mozilla/5.0, (Windows NT 6.1;,房车:2.0.1),壁虎/20100101,Firefox/4.0.1 # 39;

]

时间=f 开放(“proxy")

时间=lines f.readlines ()

时间=proxys []

,

for 小姐:拷贝范围(0,len()行):

ip =,才能行[我].strip () .split (“”)

proxy_host =,才能“http://" + ip [0] +“:“+ ip [1]

print 才能“http://" + ip [0] +“:“+ ip [1]

proxy_temp 才能=,{“http": proxy_host}

proxys.append才能(proxy_temp)

urls =, {“https://blog.csdn.net/Lin_QC/article/details/88966839"

,,,“https://blog.csdn.net/Lin_QC/article/details/88930018"

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

null

这篇文章给大家介绍使用python爬虫怎么增加访问量,内容非常详细,感兴趣的小伙伴们可以参考借鉴,希望对大家能有所帮助。

该代码主要就是利用爬虫打开网页来进行访问量的刷新,但是,该方法遇到了瓶颈,当刷新到一定访问量时,csdn的服务器会阻止该ip的访问,也就刷新不了访问量了。

所以,也就衍生了第二版。

我们可以在,https://www.xicidaili.com网站上看到很多代理ip、使用这些代理ip,可以防止csdn服务器阻止访问。

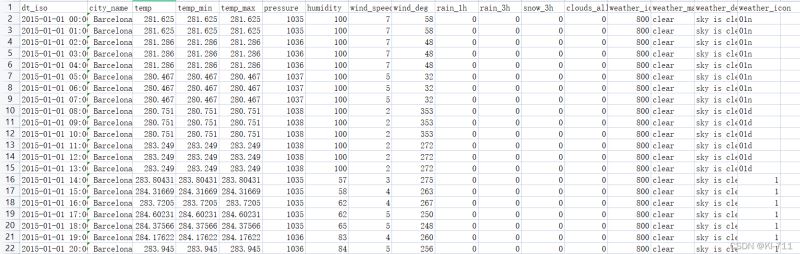

首先,编写了一个获取代理ip的文件,经我本人实验,国内http代理ip较为稳定,所以我们爬取

& # 39; https://www.xicidaili.com/wt/1

页面的代理ip信息,并将它们存储在代理文件里,以下代码是基于python2的,注意不要弄错版本

proxy_IP。py文件

通过执行以上代码,我们就可以获得大量代理ip,接下来就是使用这些ip进行对博客的访问。

csdnfake。py