<强>

<强>

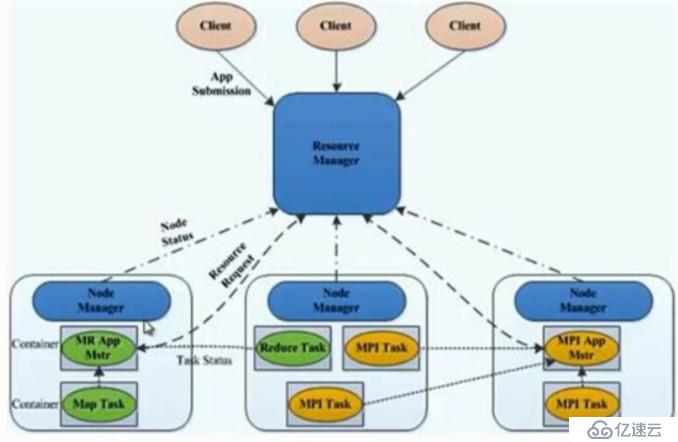

?纱是Hadoop的一个通用的资源管理系统

?纱角色

,,,,, Resourcemanager

,,,,, Nodemanager

,,,,, ApplicationMaster

,,,,,容器

,,,,,客户

?ResourceManager

,,,,,处理客户端请求

,,,,,启动/监控ApplicationMaster

,,,,,监控NodeManager

,,,,,资源分配与调度

?NodeManager

,,,,,单个节点上的资源管理

,,,,,处理来自ResourceManager的命令

,,,,,处理来自ApplicationMaster的命令

?容器

,,,,,对任务运行行环境的抽象,封装了CPU、内存等

,,,,,多维资源以及环境变量,启动命令等任务运行相关的信息资源分配与调度

?ApplicationMaster

,,,,,数据切分

,,,,,为应用程序申请资源,并分配给内部任务

,,,,,任务监控与容错

?客户

,,,,,用户与纱线交互的客户端程序

,,,,,提交应用程序,监控应用程序状态,杀死应用程序等

纱结构

?纱的核心思想

?将JobTracker和TaskTacker进行分离,它由下面几大构成组件:

,,,,, ResourceManager一个全局的资源管理器

,,,,, NodeManager每个节点(RM)代理

,,,,, ApplicationMaster表示每个应用

,,,,,每一个ApplicationMaster有多个容器在NodeManager上运行

<强>

主机,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,角色,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,软件

192.168.4.1 ,,, master ,,,,,资源Manager ,,,,,,纱

192.168.4.2 ,,, node1 ,,,,,,节点Manager ,,,,,,,,,,纱

192.168.4.3 ,,, node2 ,,,,,,节点Manager ,,,,,,,,,,,,,,纱

192.168.4.4 ,,, node3 ,,,,,,,节点Manager ,,,,,,,,,,,,,,,纱

<强> ,,,,,

具体实验准备可以参考,https://blog.51cto.com/13558754/2066708

# ssh 192.168.4.1

# cd/usr/local/hadoop/

# cd等/hadoop/

# cp mapred-site.xml。模板mapred-site。xml

# vim mapred-site.xml

& lt; configuration>

,& lt; property>

,,& lt; name> mapreduce.framework.name

,,& lt; value> yarn,,,,,,,,,,,,,,,,,,,,,,,,//配置使用纱资源管理系统

,& lt;/property>

& lt;/configuration>

# vim yarn-site.xml

& lt; configuration>

,& lt; property>

,,& lt; name> yarn.resourcemanager.hostname

,,& lt; value> master,,,,,,,,,,,,,,,,//配置,资源管理器角色,

,& lt;/property>

,& lt; property>

,,& lt; name> yarn.nodemanager.aux-services

,,& lt; value> mapreduce_shuffle,,,,,,,,,,,,//一个java的类真实环境与开发人员沟通

,& lt;/property>

& lt;/configuration>

配置完成以后

#我在节点{3}1 . .,,,,,,,,,,,,,,,,,,,,//将配置文件同步到所有主机

比;

比;rsync -azSH——delete/usr/local/hadoop/etc/hadoop/${我}:/usr/地方/hadoop/etc/hadoop - e & # 39; ssh # 39;

比;完成了

# cd/usr/local/hadoop/

启动纱服务

#。/sbin/start-yarn.sh

在所有主机上执行译本,查看是否启动成功

#我在主节点{3}1 . .

比;

比;echo ${我}

比;ssh ${我}“jps"

比;null