这篇文章主要介绍“常用的大数据分析模型有哪些以及大数据的特征有哪些”,在日常操作中,相信很多人在常用的大数据分析模型有哪些以及大数据的特征有哪些问题上存在疑惑,小编查阅了各式资料,整理出简单好用的操作方法,希望对大家解答”常用的大数据分析模型有哪些以及大数据的特征有哪些”的疑惑有所帮助!接下来,请跟着小编一起来学习吧!

现如今会上如果不说两句大数据、云计算、区块链、边缘计算等名词,就感觉被时代抛弃一样。那今天我们主要为大家讲解下什么是大数据;在做大数据可视化时,有哪些常见得到数据分析模型。

那么什么是大数据呢?

大数据(Big Data)概念是1998年由SGI首席科学家John Masey在USENIX大会上提出的。他当时发表了一篇名为Big Data and the Next Wave of Infrastress的论文,使用了大数据来描述数据爆炸的现象。但大数据真正得到业界关注,则是其后多年的事情了。其中大数据最重要的发酵素则是2003-2006年Google发布的GFS、MapReduce和BigTable三篇论文。

大数据是指海量数据或巨量数据,其规模巨大到无法通过目前主流的计算机系统在合理时间内获取、存储、管理、处理并提炼以帮助使用者决策。

大数据有哪些特征呢?

大数据的5V特征,即Variety(多样化)、Volume(大量化)、Velocity(快速化)、Value(价值密度低)、Veracity(真实性)。其中,Variety表示来源多和格式多,数据可以来源于搜索引擎、社交网络、通话记录、传感器等等,这些数据要么以结构化形式存储,要么以非结构化数据存储;Volume表示数据量比较大,从TB级别,跃升到PB级别。尤其是在移动互联时代,视频、语言等非结构化数据快速增长;Velocity表示数据存在时效性,需要快速处理,并得到结果出来,这一点也是和传统的数据挖掘技术有着本质的区别;Value表示大量不相关信息,不经过处理则价值较低,属于价值密度低的数据。Veracity(真实性)数据质量因数据来源以及记录方式等影响因素的不同,会出现较大的差异,而这种差异性会极大程度地影响数据分析的精确性

大数据处理流程是怎么样的呢?

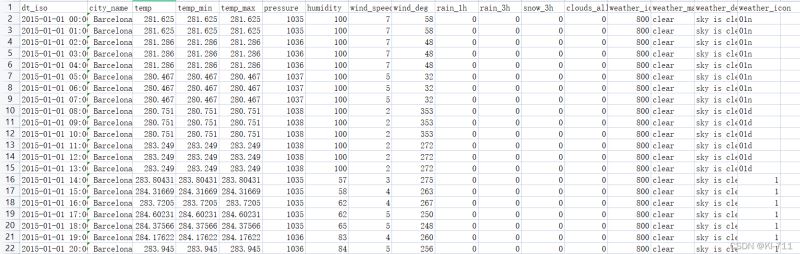

一般的大数据处理流程都有以下几个过程:数据采集、数据存储、数据处理、数据展现。如下图所示。

简而言之,大数据就是数据量非常大、数据种类繁多、无法用常规归类方法应用计算的数据集成。

有了这么多的大数据,我们如何使用呢?

通过不同渠道采集来的数据,经过对数据清洗后,那接下来就是应用大数据的时候了。根据我们的需求目标定义不同的数据模型,通过数据模型对数据进行筛选,获得我们需要的数据。那么在我们日常工作中有哪些常用的大数据模型呢?今天我们主要分析几个常用的模型做简单的介绍。供大家参考。

1、行为事件分析

行为事件分析法:顾名思义主要通过事件的行为来分析,获得有效的数据。目前主要是用来来研究某行为事件的发生对企业组织价值的影响以及影响程度。那么我们的企业可以借此来追踪或记录的用户行为或业务过程。比如用户注册、浏览产品详情页、购买、提现等,通过研究与事件发生关联的所有因素来挖掘用户行为事件背后的原因、交互影响等。

在日常工作中,运营、市场、产品、数据分析师根据实际工作情况而关注不同的事件指标。如最近三个月来自哪个渠道的用户注册量最高?变化趋势如何?各时段的人均充值金额是分别多少?上周来自北京发生过购买行为的独立用户数,按照年龄段的分布情况?每天的独立Session数是多少?诸如此类的指标查看的过程中,行为事件分析起到重要作用。

行为事件分析法具有强大的筛选、分组和聚合能力,逻辑清晰且使用简单,已被广泛应用。行为事件分析法一般经过事件定义与选择、下钻分析、解释与结论等环节。尤其是电商公司通过前期的用户行为数据的采集,在促销活动中就可以有目的的区域性,定制性用户广告投放。通过精准的用户行为数据分析,可获得更高精准用户的转化率。

2、漏斗分析模型

漏斗分析是一套流程分析,它能够科学反映用户行为状态以及从起点到终点各阶段用户转化率情况的重要分析模型。其实企业经营中经常使用到,最简单的应该是我们销售部门的销售项目漏斗。销售管理者通过项目漏斗来分析接下来重点项目跟进和赢单概率。销售漏斗也是一种数据分析模型。