一:安装logstash(下载tar包安装也行,我直接百胜装了)

# yum install logstash-2.1.1

二:从github上克隆代码

# git clone https://github.com/heqin5136/logstash-output-webhdfs-discontinued.git

# ls

logstash-output-webhdfs-discontinued

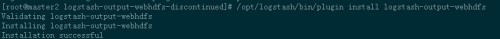

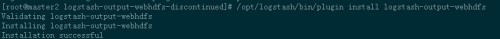

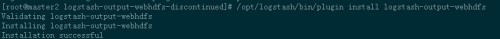

三:安装logstash-output-webhdfs插件

# cd logstash-output-webhdfs-discontinued

logstash的本目录下有个插件,使用插件来安装插件

#/opt/logstash/bin/plugin install logstash-output-webhdfs

四:配置logstash

# vim /etc/logstash conf.d/logstash.conf

input {

kafka {才能

,,,zk_connect =祝辞,“10.10.10.1:2181、10.10.10.2:2181 10.10.10.3:2181‘,,,#卡夫卡的zk集群地址

,,,group_id =祝辞,hdfs的,,,,,,,,,,,,,,,,,,,,,#消费者组,不要和麋鹿上的消费者一样

,,,topic_id =祝辞,“apiAppWebCms-topic”,,,,,,, # topic

,,,consumer_id =祝辞,‘logstash-consumer-10.10.8.8’,,, #消费者id、自定义,我写本机ip。

,,,consumer_threads =祝辞;1

,,,queue_size =在200年

,,,codec =祝辞,json的

,,}

}

output {,,,,,,,,,,,

#如果你一个话题中会有好几种日志,可以提取出来分开存储在hdfs上。

if [型],==,“apiNginxLog”, {

,,,webhdfs {

,,,,,,,,,,workers =祝辞;2

,,,,,,,,,,host =祝辞,“10.10.8.1”,,,,,,,,# hdfs的namenode地址,,,,

,,,,,,,,,,port =祝辞,50070,,,,,,,,,,,,,,# webhdfs端口

,,,,,,,,,,user =祝辞,“hdfs”,,,,,,,,,,,,, # hdfs运行的用户啊,以这个用户的权限去写hdfs。

,,,,,,,,,,path =祝辞,”/数据/logstash/apiNginxLog - % {+ YYYY} - % {+ MM} % {+ dd}/logstash - % {+ HH} .log

,,,,,,,,,,,,#按天建目录,按小时建日志文件。

,,,,,,,,,,flush_size =在500年

#,,,,,,,compression =祝辞,“时髦的”,,,,,,,,,,,,,#压缩格式,可以不压缩

,,,,,,,idle_flush_time =在10

,,,,,,,retry_interval =在0.5

,,,,,,}

,,}

if [型],==,“apiAppLog”, {

,,,webhdfs {

,,,,,,,workers =祝辞;2

,,,,,,,host =祝辞,“10.64.8.1”

,,,,,,,port =在50070年

,,,,,,,user =祝辞,“hdfs”

,,,,,,,path =祝辞,"/数据/logstash/api/apiAppLog - % {+ YYYY} % {+ MM} - % {+ dd} . log”

,,,,,,,flush_size =在500年

#,,,,,,,,compression =祝辞,“时髦的”

,,,,,,,idle_flush_time =在10

,,,,,,,retry_interval =在0.5

,,,,,,}

,,}

{stdout 才能;codec =祝辞,rubydebug }

} ,

五:启动logstash

#/etc/摆在logstash 开始

已经可以成功写入了。